Wenn du mit Unix-Timestamps arbeitest, kann die Wahl zwischen Seconds vs Milliseconds vs Microseconds die Performance deiner Anwendung, die Speicheranforderungen und die Präzision erheblich beeinflussen. Während Unix-Timestamps traditionell die Zeit in Sekunden seit dem 1. Januar 1970 messen, erfordern moderne Anwendungen oft höhere Präzision für das Protokollieren von Ereignissen, das Messen von API-Antwortzeiten oder die Synchronisierung verteilter Systeme. Dieser Leitfaden erklärt die praktischen Unterschiede zwischen den einzelnen Präzisionsstufen und liefert klare Kriterien, die dir helfen, die richtige Wahl für deinen spezifischen Anwendungsfall zu treffen.

Inhaltsverzeichnis

- Die drei Präzisionsstufen verstehen

- Speicher- und Performance-Auswirkungen

- Wann du Sekunden verwenden solltest

- Wann du Millisekunden verwenden solltest

- Wann du Mikrosekunden verwenden solltest

- Fallstudie: E-Commerce-Bestellverarbeitungssystem

- Best Practices für die Wahl der Timestamp-Präzision

- Fazit

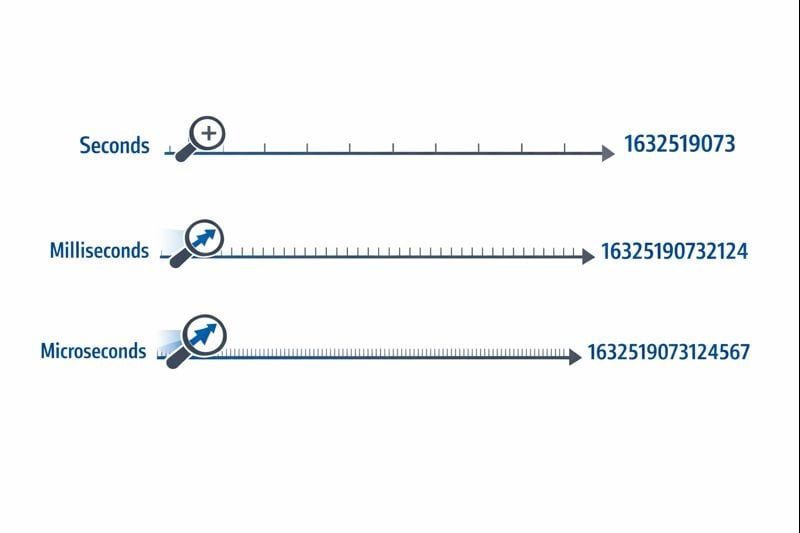

Die drei Präzisionsstufen verstehen

Unix-Timestamps stellen Zeit als einzelne Zahl dar, die vom Epoch-Time-Referenzpunkt an zählt. Die Präzisionsstufe bestimmt, wie fein du Zeitintervalle messen kannst.

Sekunden (10 Ziffern): Das ursprüngliche Unix-Timestamp-Format verwendet einen 32-Bit- oder 64-Bit-Integer, der ganze Sekunden darstellt. Ein typischer Wert sieht aus wie 1704067200

, was genau einen Moment in der Zeit ohne Unterteilungen repräsentiert.

Millisekunden (13 Ziffern): Dieses Format multipliziert den Sekundenwert mit 1.000 und fügt drei Dezimalstellen Präzision hinzu. Derselbe Moment wird zu 1704067200000

. JavaScripts Date.now()

-Funktion gibt Timestamps standardmäßig in diesem Format zurück.

Mikrosekunden (16 Ziffern): Wird hauptsächlich in Systemen verwendet, die extreme Präzision erfordern, dieses Format multipliziert Sekunden mit 1.000.000. Der Wert wird zu 1704067200000000

. Sprachen wie Pythons time.time_ns()

können sogar mit Nanosekunden-Präzision arbeiten (19 Ziffern), obwohl Mikrosekunden die praktische Obergrenze für die meisten Anwendungen darstellen.

Die von dir gewählte Präzisionsstufe beeinflusst direkt deine Datenbankgröße, den Speicherverbrauch und die Query-Performance. Diese Einschränkungen werden kritisch, wenn deine Anwendung skaliert.

Speicheranforderungen

Ein 32-Bit-Integer (4 Bytes) kann Timestamps auf Sekundenebene bis zum Auftreten des Jahr-2038-Problems speichern. Die meisten modernen Systeme verwenden 64-Bit-Integer (8 Bytes), um diese Einschränkung zu vermeiden.

- Sekunden: 8 Bytes für einen vorzeichenbehafteten 64-Bit-Integer (BIGINT)

- Millisekunden: 8 Bytes für einen vorzeichenbehafteten 64-Bit-Integer (BIGINT)

- Mikrosekunden: 8 Bytes für einen vorzeichenbehafteten 64-Bit-Integer (BIGINT)

Während jede Präzisionsstufe in modernen Datenbanken denselben 8-Byte-Speicher verwendet, kommt die tatsächliche Auswirkung von Indizierungs- und Query-Operationen. Größere Zahlen erfordern mehr CPU-Zyklen für Vergleichsoperationen, und Index-B-Trees werden mit größeren Schlüsselwerten etwas weniger effizient.

Datenbank-Query-Performance

Wenn du mit Unix-Timestamps in Datenbanken arbeitest, beeinflusst die Präzisionsstufe Bereichsabfragen und Sortieroperationen. Eine Datenbank, die 10-stellige Zahlen vergleicht, arbeitet geringfügig schneller als beim Vergleich von 16-stelligen Zahlen, obwohl der Unterschied erst bei Millionen von Zeilen bemerkbar wird.

Kritischer ist, dass das Mischen von Präzisionsstufen in deiner Datenbank Konvertierungs-Overhead erzeugt. Wenn deine Anwendungsschicht Millisekunden-Timestamps sendet, aber deine Datenbank Sekunden speichert, erfordert jede Abfrage eine Division durch 1.000, was eine effiziente Indexnutzung verhindert.

Netzwerk- und API-Überlegungen

JSON-Payloads übertragen Timestamps als Strings oder Zahlen. Ein 16-stelliger Mikrosekunden-Timestamp fügt 6 zusätzliche Zeichen im Vergleich zu einem 10-stelligen Sekunden-Timestamp hinzu. Über Millionen von API-Aufrufen hinweg verursacht dies messbare Bandbreitenkosten und Serialisierungs-Overhead.

Wann du Sekunden verwenden solltest

Sekunden-Präzision bleibt die beste Wahl für die meisten benutzerseitigen Features, bei denen die menschliche Wahrnehmung die relevante Zeitskala definiert.

Ideale Anwendungsfälle

- Social-Media-Posts und Kommentare: Nutzer nehmen Unterschiede unter einer Sekunde nicht wahr

- Geplante Aufgaben und Cron-Jobs: Die meiste Automatisierung läuft auf Minuten- oder Stundengrenzen

- Benutzer-Authentifizierungs-Token: Session-Ablauf erfordert keine Genauigkeit unter einer Sekunde

- Content-Veröffentlichungsdaten: Artikel, Videos und Blogposts verwenden Sekunden-Präzision

- Buchungs- und Reservierungssysteme: Termine richten sich typischerweise an Minuten- oder Stundenslots aus

Umsetzbare Implementierungsschritte

Um Timestamps auf Sekundenebene effektiv zu implementieren:

- Verwende

BIGINT-Spalten in deiner Datenbank, um vorzeichenbehaftete 64-Bit-Integer zu speichern - Erstelle Indizes auf Timestamp-Spalten für Bereichsabfragen wie "Posts der letzten 24 Stunden"

- Konvertiere in JavaScript Millisekunden-Timestamps:

Math.floor(Date.now() / 1000) - Verwende in Python:

int(time.time()) - Dokumentiere deine Präzisionswahl in API-Spezifikationen, damit Konsumenten wissen, ob sie mit 1.000 multiplizieren müssen

Wann du Millisekunden verwenden solltest

Millisekunden-Präzision wird notwendig, wenn du Ereignisse verfolgen musst, die mehrmals pro Sekunde auftreten, oder Zeitspannen messen musst, die kürzer als eine Sekunde sind.

Ideale Anwendungsfälle

- API-Antwortzeit-Monitoring: Verfolgen, ob Endpoints innerhalb von 200ms oder 800ms antworten

- Finanztransaktionen: Aufzeichnen der exakten Reihenfolge von Trades oder Zahlungsverarbeitungsschritten

- Echtzeit-Messaging: Ordnen von Chat-Nachrichten, die innerhalb derselben Sekunde gesendet wurden

- Video-Streaming-Analytics: Aufzeichnen von Wiedergabe-Events und Buffering-Vorfällen

- Koordination verteilter Systeme: Synchronisieren von Ereignissen über mehrere Server hinweg

Umsetzbare Implementierungsschritte

Um Timestamps auf Millisekundenebene zu implementieren:

- Verwende

BIGINT-Spalten in deiner Datenbank mit klarer Dokumentation, dass Werte Millisekunden darstellen - Verwende in JavaScript

Date.now()direkt (gibt standardmäßig Millisekunden zurück) - Verwende in Python:

int(time.time() * 1000) - Für Discord-Timestamps und ähnliche Plattformen bieten Millisekunden die Standard-Präzision

- Füge Validierung auf Anwendungsebene hinzu, um sicherzustellen, dass Timestamps in vernünftige Bereiche fallen (nicht versehentlich in Sekunden oder Mikrosekunden)

Einschränkungen in der Praxis

Millisekunden-Präzision führt eine subtile Herausforderung ein: Nicht alle Systeme erzeugen wirklich genaue Millisekunden-Timestamps. Die Auflösung der Betriebssystem-Uhr variiert, und virtualisierte Umgebungen aktualisieren ihre Uhren möglicherweise nur alle 10-15 Millisekunden. Deine Timestamps könnten falsche Präzision zeigen, wenn die zugrunde liegende Uhr keine echte Millisekunden-Genauigkeit unterstützt.

Wann du Mikrosekunden verwenden solltest

Mikrosekunden-Präzision ist für die meisten Anwendungen übertrieben, wird aber in spezialisierten Bereichen, die extreme Genauigkeit erfordern, essenziell.

Ideale Anwendungsfälle

- Hochfrequenzhandelssysteme: Aufzeichnen von Orderbuch-Updates, die tausende Male pro Sekunde auftreten

- Performance-Profiling und Benchmarking: Messen von Funktionsausführungszeiten im Mikrosekundenbereich

- Wissenschaftliche Datenerfassung: Protokollieren von Sensor-Messwerten oder experimentellen Messungen

- Netzwerkpaket-Analyse: Erfassen des exakten Timings von Netzwerkereignissen für Sicherheit oder Debugging

- Audio/Video-Verarbeitung: Synchronisieren von Multimedia-Streams auf Frame- oder Sample-Ebene

Umsetzbare Implementierungsschritte

Um Timestamps auf Mikrosekundenebene zu implementieren:

- Überprüfe, ob deine Programmiersprache und Datenbank Mikrosekunden-Präzision unterstützen (nicht alle tun das)

- Verwende in Python:

int(time.time() * 1_000_000) - Verwende in C/C++

gettimeofday()oderclock_gettime()mitCLOCK_REALTIME - Erwäge die Verwendung spezialisierter Zeitreihen-Datenbanken wie InfluxDB oder TimescaleDB, die für hochpräzise Timestamps konzipiert sind

- Dokumentiere die Präzisionsanforderung klar, da die meisten Entwickler standardmäßig Millisekunden annehmen werden

Einschränkungen in der Praxis

Mikrosekunden-Timestamps erzeugen erhebliche Herausforderungen in verteilten Systemen. Netzwerk-Latenz misst typischerweise in Millisekunden, was eine Synchronisierung auf Mikrosekundenebene über Server hinweg ohne spezialisierte Hardware wie GPS-synchronisierte Uhren nahezu unmöglich macht. Wenn deine Anwendung über mehrere Rechenzentren läuft, könnte Mikrosekunden-Präzision falsche Genauigkeit liefern.

Fallstudie: E-Commerce-Bestellverarbeitungssystem

Hypothetische Fallstudie:

Das folgende Beispiel demonstriert Entscheidungsfindung in der Praxis für Timestamp-Präzision. Obwohl das Unternehmen fiktiv ist, repräsentieren die technischen Einschränkungen und Lösungen gängige Szenarien.

ShopFast, eine mittelgroße E-Commerce-Plattform, baute ihr Bestellverarbeitungssystem zunächst mit Unix-Timestamps auf Sekundenebene auf. Als sie auf die Verarbeitung von 500 Bestellungen pro Minute während Spitzenzeiten skalierten, stießen sie auf ein kritisches Problem.

Das Problem

Mehrere Bestellungen, die innerhalb derselben Sekunde aufgegeben wurden, konnten nicht zuverlässig sortiert werden. Wenn Kunden den Support kontaktierten und fragten "welche Bestellung ging zuerst durch?", konnte das System keine definitive Antwort liefern. Noch kritischer war, dass ihr Betrugspräventionssystem kennzeichnen musste, wenn dieselbe Kreditkarte für mehrere Käufe innerhalb eines kurzen Zeitfensters verwendet wurde, aber Sekunden-Präzision machte dies unzuverlässig.

Die Analyse

Das Engineering-Team bewertete ihre Anforderungen über verschiedene Systemkomponenten hinweg:

- Bestellerstellungs-Timestamps: Erforderten Millisekunden-Präzision für korrekte Sequenzierung

- Produktkatalog last_updated-Felder: Sekunden-Präzision blieb ausreichend

- Zahlungsverarbeitungs-Logs: Erforderten Millisekunden-Präzision für Betrugserkennung

- Kundenkonto-Erstellungsdaten: Sekunden-Präzision blieb ausreichend

- API-Request-Logging: Erforderte Millisekunden-Präzision für Performance-Monitoring

Die Lösung

Anstatt ihre gesamte Datenbank auf Millisekunden umzustellen, implementierten sie einen Hybrid-Ansatz:

- Migrierten

orders.created_atvon Sekunden auf Millisekunden durch Multiplikation der bestehenden Werte mit 1.000 - Aktualisierten ihre API-Schicht, um Millisekunden-Timestamps für bestellbezogene Endpoints zu akzeptieren und zurückzugeben

- Ließen benutzerseitige Timestamps (Kontoerstellung, letzter Login) in Sekunden, um den Migrations-Umfang zu minimieren

- Fügten klare Dokumentation hinzu, die unterschied, welche Felder welche Präzision verwendeten

- Implementierten Validierung auf Anwendungsebene, um versehentliche Präzisions-Inkonsistenzen zu erkennen

Die Ergebnisse

Nach der Migration konnte das System Bestellungen zuverlässig sequenzieren und Betrugsmuster erkennen. Die Speicherzunahme war vernachlässigbar (Hinzufügen von drei Ziffern zu bestehenden Zahlen), aber die verbesserte Funktionalität rechtfertigte den Migrationsaufwand. Die Query-Performance blieb praktisch identisch, da sie die korrekte Indizierung beibehielten.

Die wichtigste Lektion: du benötigst keine einheitliche Präzision über deine gesamte Anwendung hinweg. Wähle die geeignete Stufe für jeden spezifischen Anwendungsfall basierend auf tatsächlichen Anforderungen, nicht auf theoretischen Bedenken.

Best Practices für die Wahl der Timestamp-Präzision

Folge diesen Richtlinien beim Implementieren von Unix-Timestamps in deinen Anwendungen:

1. Beginne mit Sekunden, upgrade nur wenn nötig

Setze standardmäßig auf Sekunden-Präzision, es sei denn, du hast eine spezifische Anforderung für feinere Granularität. Vorzeitige Optimierung verschwendet Entwicklungszeit und erzeugt unnötige Komplexität. Die meisten Anwendungen benötigen niemals Präzision unter einer Sekunde.

2. Behalte Konsistenz innerhalb von Domänen bei

Verwende dieselbe Präzisionsstufe für zusammenhängende Timestamps. Wenn deine orders

-Tabelle Millisekunden verwendet, sollten deine order_items

- und order_payments

-Tabellen übereinstimmen. Das Mischen von Präzisionsstufen erzwingt ständige Konvertierung und erzeugt Bugs.

3. Dokumentiere deine Präzisionswahl

Füge Kommentare in deinem Datenbankschema, deiner API-Dokumentation und deinem Code hinzu, die erklären, ob Timestamps Sekunden, Millisekunden oder Mikrosekunden darstellen. Ein Timestamp-Wert von 1704067200000

ist ohne Kontext mehrdeutig.

4. Validiere Timestamp-Bereiche

Implementiere Validierung, um Präzisionsfehler zu erkennen. Ein Timestamp in Sekunden sollte für aktuelle Daten zwischen etwa 1.000.000.000 (September 2001) und 2.000.000.000 (Mai 2033) liegen. Ein Millisekunden-Timestamp sollte ungefähr 1.000-mal größer sein. Das frühe Erkennen dieser Fehler verhindert Datenbeschädigung.

5. Berücksichtige die nativen Typen deiner Datenbank

Einige Datenbanken bieten native Timestamp-Typen mit eingebauter Präzision. PostgreSQLs TIMESTAMP

-Typ speichert intern Mikrosekunden-Präzision. MySQLs DATETIME

-Typ unterstützt Mikrosekunden seit Version 5.6.4. Diese nativen Typen bieten oft bessere Query-Optimierung als das Speichern roher Integer.

6. Berücksichtige Clock Drift in verteilten Systemen

Wenn du Timestamps vergleichst, die von verschiedenen Servern generiert wurden, kann selbst Millisekunden-Präzision ohne korrekte Uhr-Synchronisierung irreführend sein. Implementiere NTP (Network Time Protocol) auf allen Servern und erwäge die Verwendung logischer Uhren (wie Lamport-Timestamps oder Vektor-Uhren) für die Ordnung von Ereignissen in verteilten Systemen.

7. Teste Konvertierungslogik gründlich

Beim Konvertieren zwischen Präzisionsstufen teste Grenzfälle wie negative Timestamps (Daten vor 1970), sehr große Timestamps (weit in der Zukunft liegende Daten) und die Grenzen deiner Integer-Typen. Ein 32-Bit-Integer kann keine Millisekunden-Timestamps über 2038 hinaus speichern.

8. Plane für das Jahr-2038-Problem

Wenn du Timestamps auf Sekundenebene verwendest, stelle sicher, dass du 64-Bit-Integer verwendest, nicht 32-Bit. Das Jahr-2038-Problem betrifft nur vorzeichenbehaftete 32-Bit-Integer. Das Befolgen der Unix-Timestamp-Tutorial-Best-Practices hilft, deine Anwendung zukunftssicher zu machen.

Fazit

Die Wahl zwischen Seconds vs Milliseconds vs Microseconds für Unix-Timestamps hängt von deinen spezifischen Anwendungsanforderungen ab, nicht von willkürlichen technischen Präferenzen. Sekunden-Präzision handhabt die meisten benutzerseitigen Features effizient, Millisekunden-Präzision ermöglicht API-Monitoring und Echtzeit-Koordination, und Mikrosekunden-Präzision dient spezialisierten Hochfrequenz-Anwendungen. Beginne mit der einfachsten Option, die deine Anforderungen erfüllt, behalte Konsistenz innerhalb zusammenhängender Daten bei und dokumentiere deine Entscheidungen klar. Indem du die praktischen Trade-offs zwischen Speicher, Performance und Präzision verstehst, kannst du informierte Entscheidungen treffen, die mit dem Wachstum deiner Anwendung skalieren.

Konvertiere sofort zwischen Timestamp-Formaten

Wechsle zwischen Sekunden, Millisekunden und Mikrosekunden mit unserem kostenlosen Unix-Timestamp-Konverter. Kein Programmieren erforderlich.

Probiere unser kostenloses Tool aus →