Gdy pracujesz z uniksowymi znacznikami czasu, wybór między seconds vs milliseconds vs microseconds może znacząco wpłynąć na wydajność Twojej aplikacji, wymagania dotyczące przechowywania danych i precyzję. Chociaż uniksowe znaczniki czasu tradycyjnie mierzą czas w sekundach od 1 stycznia 1970 roku, nowoczesne aplikacje często wymagają wyższej precyzji do logowania zdarzeń, mierzenia czasów odpowiedzi API czy synchronizacji systemów rozproszonych. Ten przewodnik przedstawia praktyczne różnice między każdym poziomem precyzji i dostarcza jasnych kryteriów, które pomogą Ci dokonać właściwego wyboru dla Twojego konkretnego przypadku użycia.

Spis treści

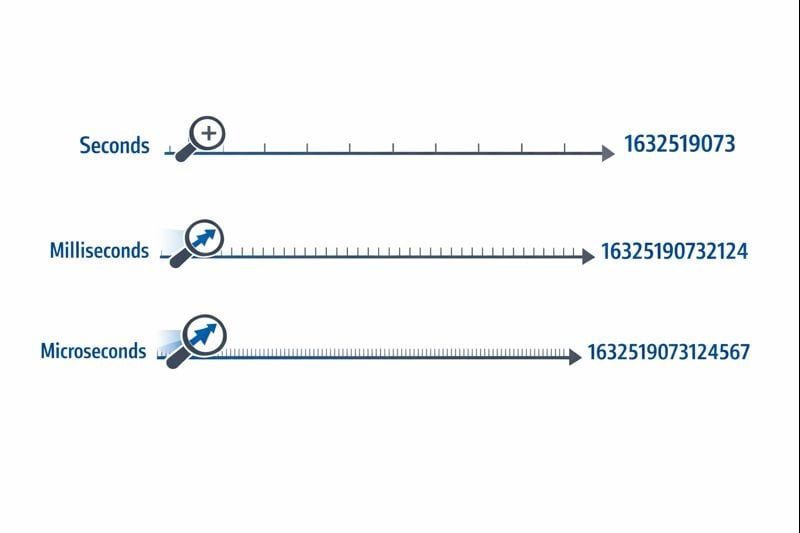

Zrozumienie trzech poziomów precyzji

Uniksowe znaczniki czasu reprezentują czas jako pojedynczą liczbę liczoną od punktu odniesienia epoch time. Poziom precyzji określa, jak dokładnie możesz mierzyć interwały czasowe.

Sekundy (10 cyfr): Oryginalny format uniksowego znacznika czasu używa 32-bitowej lub 64-bitowej liczby całkowitej reprezentującej pełne sekundy. Typowa wartość wygląda jak 1704067200, co reprezentuje dokładnie jeden moment w czasie bez podziałów.

Milisekundy (13 cyfr): Ten format mnoży wartość sekund przez 1000, dodając trzy miejsca dziesiętne precyzji. Ten sam moment staje się 1704067200000. Funkcja JavaScript Date.now() domyślnie zwraca znaczniki czasu w tym formacie.

Mikrosekundy (16 cyfr): Używane głównie w systemach wymagających ekstremalnej precyzji, ten format mnoży sekundy przez 1 000 000. Wartość staje się 1704067200000000. Języki takie jak Python z funkcją time.time_ns() mogą pracować nawet z precyzją nanosekundową (19 cyfr), choć mikrosekundy reprezentują praktyczną górną granicę dla większości aplikacji.

Wpływ na przechowywanie i wydajność

Wybrany przez Ciebie poziom precyzji bezpośrednio wpływa na rozmiar bazy danych, zużycie pamięci i wydajność zapytań. Te ograniczenia stają się krytyczne, gdy Twoja aplikacja się skaluje.

Wymagania dotyczące przechowywania

32-bitowa liczba całkowita (4 bajty) może przechowywać znaczniki czasu na poziomie sekund do momentu wystąpienia problemu roku 2038. Większość nowoczesnych systemów używa 64-bitowych liczb całkowitych (8 bajtów), aby uniknąć tego ograniczenia.

- Sekundy: 8 bajtów dla 64-bitowej liczby całkowitej ze znakiem (BIGINT)

- Milisekundy: 8 bajtów dla 64-bitowej liczby całkowitej ze znakiem (BIGINT)

- Mikrosekundy: 8 bajtów dla 64-bitowej liczby całkowitej ze znakiem (BIGINT)

Chociaż każdy poziom precyzji używa tej samej 8-bajtowej przestrzeni w nowoczesnych bazach danych, rzeczywisty wpływ pochodzi z operacji indeksowania i zapytań. Większe liczby wymagają więcej cykli CPU do operacji porównania, a drzewa B indeksów stają się nieco mniej wydajne przy większych wartościach kluczy.

Wydajność zapytań bazodanowych

Gdy pracujesz z uniksowymi znacznikami czasu w bazach danych, poziom precyzji wpływa na zapytania zakresowe i operacje sortowania. Baza danych porównująca 10-cyfrowe liczby działa marginalnie szybciej niż porównująca 16-cyfrowe liczby, choć różnica staje się zauważalna dopiero przy milionach wierszy.

Co bardziej krytyczne, mieszanie poziomów precyzji w Twojej bazie danych tworzy narzut konwersji. Jeśli Twoja warstwa aplikacji wysyła znaczniki czasu w milisekundach, ale baza danych przechowuje sekundy, każde zapytanie wymaga dzielenia przez 1000, uniemożliwiając efektywne wykorzystanie indeksów.

Kwestie sieciowe i API

Payloady JSON przesyłają znaczniki czasu jako ciągi znaków lub liczby. 16-cyfrowy znacznik czasu w mikrosekundach dodaje 6 dodatkowych znaków w porównaniu do 10-cyfrowego znacznika czasu w sekundach. Przy milionach wywołań API przekłada się to na mierzalne koszty przepustowości i narzut serializacji.

Kiedy używać sekund

Precyzja na poziomie sekund pozostaje najlepszym wyborem dla większości funkcji skierowanych do użytkowników, gdzie ludzka percepcja definiuje odpowiednią skalę czasu.

Idealne przypadki użycia

- Posty i komentarze w mediach społecznościowych: Użytkownicy nie dostrzegają różnic poniżej jednej sekundy

- Zaplanowane zadania i zadania cron: Większość automatyzacji działa na granicach minut lub godzin

- Tokeny uwierzytelniania użytkowników: Wygaśnięcie sesji nie wymaga dokładności poniżej sekundy

- Daty publikacji treści: Artykuły, filmy i posty blogowe używają precyzji na poziomie sekund

- Systemy rezerwacji i bookingów: Spotkania zazwyczaj wyrównują się do slotów minutowych lub godzinowych

Praktyczne kroki implementacji

Aby skutecznie wdrożyć znaczniki czasu na poziomie sekund:

- Używaj kolumn

BIGINTw swojej bazie danych do przechowywania 64-bitowych liczb całkowitych ze znakiem - Twórz indeksy na kolumnach znaczników czasu dla zapytań zakresowych typu "posty z ostatnich 24 godzin"

- W JavaScript konwertuj znaczniki czasu w milisekundach:

Math.floor(Date.now() / 1000) - W Python używaj:

int(time.time()) - Dokumentuj swój wybór precyzji w specyfikacjach API, aby konsumenci wiedzieli, czy mnożyć przez 1000

Kiedy używać milisekund

Precyzja milisekundowa staje się konieczna, gdy musisz śledzić zdarzenia występujące wielokrotnie w ciągu sekundy lub mierzyć czasy trwania krótsze niż jedna sekunda.

Idealne przypadki użycia

- Monitorowanie czasu odpowiedzi API: Śledzenie, czy endpointy odpowiadają w ciągu 200ms czy 800ms

- Transakcje finansowe: Rejestrowanie dokładnej sekwencji transakcji lub kroków przetwarzania płatności

- Komunikatory czasu rzeczywistego: Porządkowanie wiadomości czatu wysłanych w tej samej sekundzie

- Analityka streamingu wideo: Rejestrowanie zdarzeń odtwarzania i incydentów buforowania

- Koordynacja systemów rozproszonych: Synchronizacja zdarzeń między wieloma serwerami

Praktyczne kroki implementacji

Aby wdrożyć znaczniki czasu na poziomie milisekund:

- Używaj kolumn

BIGINTw swojej bazie danych z jasną dokumentacją, że wartości reprezentują milisekundy - W JavaScript używaj bezpośrednio

Date.now()(domyślnie zwraca milisekundy) - W Python używaj:

int(time.time() * 1000) - Dla znaczników czasu Discord i podobnych platform milisekundy zapewniają standardową precyzję

- Dodaj walidację na poziomie aplikacji, aby upewnić się, że znaczniki czasu mieszczą się w rozsądnych zakresach (nie przypadkowo w sekundach lub mikrosekundach)

Ograniczenia w rzeczywistości

Precyzja milisekundowa wprowadza subtelne wyzwanie: nie wszystkie systemy generują naprawdę dokładne znaczniki czasu milisekundowe. Rozdzielczość zegara systemu operacyjnego różni się, a środowiska zwirtualizowane mogą aktualizować swoje zegary tylko co 10-15 milisekund. Twoje znaczniki czasu mogą pokazywać fałszywą precyzję, jeśli podstawowy zegar nie obsługuje prawdziwej dokładności milisekundowej.

Kiedy używać mikrosekund

Precyzja mikrosekundowa jest przesadą dla większości aplikacji, ale staje się niezbędna w wyspecjalizowanych dziedzinach wymagających ekstremalnej dokładności.

Idealne przypadki użycia

- Systemy high-frequency trading: Rejestrowanie aktualizacji księgi zleceń występujących tysiące razy na sekundę

- Profilowanie wydajności i benchmarking: Mierzenie czasów wykonania funkcji w zakresie mikrosekund

- Zbieranie danych naukowych: Logowanie odczytów czujników lub pomiarów eksperymentalnych

- Analiza pakietów sieciowych: Przechwytywanie dokładnego czasu zdarzeń sieciowych do celów bezpieczeństwa lub debugowania

- Przetwarzanie audio/wideo: Synchronizacja strumieni multimedialnych na poziomie klatek lub próbek

Praktyczne kroki implementacji

Aby wdrożyć znaczniki czasu na poziomie mikrosekund:

- Sprawdź, czy Twój język programowania i baza danych obsługują precyzję mikrosekundową (nie wszystkie to robią)

- W Python używaj:

int(time.time() * 1_000_000) - W C/C++ używaj

gettimeofday()lubclock_gettime()zCLOCK_REALTIME - Rozważ użycie wyspecjalizowanych baz danych szeregów czasowych jak InfluxDB lub TimescaleDB zaprojektowanych dla znaczników czasu o wysokiej precyzji

- Dokumentuj wymaganie precyzji wyraźnie, ponieważ większość programistów domyślnie zakłada milisekundy

Ograniczenia w rzeczywistości

Znaczniki czasu mikrosekundowe tworzą znaczące wyzwania w systemach rozproszonych. Opóźnienie sieciowe zazwyczaj mierzy się w milisekundach, co sprawia, że synchronizacja na poziomie mikrosekund między serwerami jest prawie niemożliwa bez specjalistycznego sprzętu jak zegary synchronizowane GPS. Jeśli Twoja aplikacja działa w wielu centrach danych, precyzja mikrosekundowa może zapewniać fałszywą dokładność.

Studium przypadku: System przetwarzania zamówień e-commerce

Hipotetyczne studium przypadku:

Poniższy przykład demonstruje rzeczywiste podejmowanie decyzji dotyczących precyzji znaczników czasu. Chociaż firma jest fikcyjna, ograniczenia techniczne i rozwiązania reprezentują typowe scenariusze.

ShopFast, średniej wielkości platforma e-commerce, początkowo zbudowała swój system przetwarzania zamówień używając uniksowych znaczników czasu na poziomie sekund. Gdy przeskalowali się do przetwarzania 500 zamówień na minutę w godzinach szczytu, napotkali krytyczny problem.

Problem

Wiele zamówień złożonych w tej samej sekundzie nie mogło być niezawodnie posortowanych. Gdy klienci kontaktowali się ze wsparciem pytając "które zamówienie przeszło pierwsze?", system nie mógł dostarczyć jednoznacznej odpowiedzi. Co bardziej krytyczne, ich system wykrywania oszustw musiał oznaczać, kiedy ta sama karta kredytowa została użyta do wielu zakupów w krótkim oknie, ale precyzja na poziomie sekund sprawiała, że było to zawodne.

Analiza

Zespół inżynieryjny ocenił swoje wymagania w różnych komponentach systemu:

- Znaczniki czasu utworzenia zamówienia: Wymagały precyzji milisekundowej do właściwego sekwencjonowania

- Pola last_updated katalogu produktów: Precyzja sekundowa pozostała wystarczająca

- Logi przetwarzania płatności: Wymagały precyzji milisekundowej do wykrywania oszustw

- Daty utworzenia kont klientów: Precyzja sekundowa pozostała wystarczająca

- Logowanie żądań API: Wymagało precyzji milisekundowej do monitorowania wydajności

Rozwiązanie

Zamiast konwertować całą bazę danych na milisekundy, wdrożyli hybrydowe podejście:

- Zmigrowali

orders.created_atz sekund na milisekundy mnożąc istniejące wartości przez 1000 - Zaktualizowali swoją warstwę API, aby akceptowała i zwracała znaczniki czasu w milisekundach dla endpointów związanych z zamówieniami

- Zostawili znaczniki czasu skierowane do użytkowników (utworzenie konta, ostatnie logowanie) w sekundach, aby zminimalizować zakres migracji

- Dodali jasną dokumentację rozróżniającą, które pola używają której precyzji

- Wdrożyli walidację na poziomie aplikacji, aby wychwycić przypadkowe niedopasowania precyzji

Wyniki

Po migracji system mógł niezawodnie sekwencjonować zamówienia i wykrywać wzorce oszustw. Wzrost przechowywania był znikomy (dodanie trzech cyfr do istniejących liczb), ale ulepszona funkcjonalność uzasadniała wysiłek migracyjny. Wydajność zapytań pozostała praktycznie identyczna, ponieważ utrzymali właściwe indeksowanie.

Kluczowa lekcja: nie potrzebujesz jednolitej precyzji w całej aplikacji. Wybierz odpowiedni poziom dla każdego konkretnego przypadku użycia na podstawie rzeczywistych wymagań, a nie teoretycznych obaw.

Najlepsze praktyki wyboru precyzji znaczników czasu

Postępuj zgodnie z tymi wytycznymi przy wdrażaniu uniksowych znaczników czasu w swoich aplikacjach:

1. Zacznij od sekund, ulepszaj tylko gdy to konieczne

Domyślnie używaj precyzji na poziomie sekund, chyba że masz konkretne wymaganie dotyczące drobniejszej granularności. Przedwczesna optymalizacja marnuje czas programistyczny i tworzy niepotrzebną złożoność. Większość aplikacji nigdy nie potrzebuje precyzji poniżej sekundy.

2. Utrzymuj spójność w domenach

Używaj tego samego poziomu precyzji dla powiązanych znaczników czasu. Jeśli Twoja tabela orders używa milisekund, Twoje tabele order_items i order_payments powinny pasować. Mieszanie poziomów precyzji wymusza ciągłą konwersję i tworzy błędy.

3. Dokumentuj swój wybór precyzji

Dodaj komentarze w schemacie bazy danych, dokumentacji API i kodzie wyjaśniające, czy znaczniki czasu reprezentują sekundy, milisekundy czy mikrosekundy. Wartość znacznika czasu 1704067200000 jest niejednoznaczna bez kontekstu.

4. Waliduj zakresy znaczników czasu

Wdróż walidację, aby wychwycić błędy precyzji. Znacznik czasu w sekundach powinien mieścić się między mniej więcej 1 000 000 000 (wrzesień 2001) a 2 000 000 000 (maj 2033) dla obecnych dat. Znacznik czasu w milisekundach powinien być około 1000 razy większy. Wczesne wychwycenie tych błędów zapobiega korupcji danych.

5. Rozważ natywne typy swojej bazy danych

Niektóre bazy danych oferują natywne typy znaczników czasu z wbudowaną precyzją. Typ TIMESTAMP PostgreSQL przechowuje wewnętrznie precyzję mikrosekundową. Typ DATETIME MySQL obsługuje mikrosekundy od wersji 5.6.4. Te natywne typy często zapewniają lepszą optymalizację zapytań niż przechowywanie surowych liczb całkowitych.

6. Uwzględnij dryfowanie zegara w systemach rozproszonych

Jeśli porównujesz znaczniki czasu generowane przez różne serwery, nawet precyzja milisekundowa może być myląca bez właściwej synchronizacji zegarów. Wdróż NTP (Network Time Protocol) na wszystkich serwerach i rozważ użycie zegarów logicznych (jak znaczniki czasu Lamporta lub zegary wektorowe) do porządkowania zdarzeń w systemach rozproszonych.

7. Testuj logikę konwersji dokładnie

Przy konwersji między poziomami precyzji testuj przypadki brzegowe jak ujemne znaczniki czasu (daty przed 1970), bardzo duże znaczniki czasu (daty w dalekiej przyszłości) i granice Twoich typów liczb całkowitych. 32-bitowa liczba całkowita nie może przechowywać znaczników czasu w milisekundach poza 2038 rokiem.

8. Planuj problem roku 2038

Jeśli używasz znaczników czasu na poziomie sekund, upewnij się, że używasz 64-bitowych liczb całkowitych, a nie 32-bitowych. Problem roku 2038 dotyczy tylko 32-bitowych liczb całkowitych ze znakiem. Przestrzeganie najlepszych praktyk tutoriala znaczników czasu Unix pomaga przygotować aplikację na przyszłość.

Podsumowanie

Wybór między seconds vs milliseconds vs microseconds dla uniksowych znaczników czasu zależy od Twoich konkretnych wymagań aplikacyjnych, a nie arbitralnych preferencji technicznych. Precyzja na poziomie sekund obsługuje większość funkcji skierowanych do użytkowników efektywnie, precyzja milisekundowa umożliwia monitorowanie API i koordynację w czasie rzeczywistym, a precyzja mikrosekundowa służy wyspecjalizowanym aplikacjom o wysokiej częstotliwości. Zacznij od najprostszej opcji, która spełnia Twoje potrzeby, utrzymuj spójność w powiązanych danych i dokumentuj swoje wybory wyraźnie. Rozumiejąc praktyczne kompromisy między przechowywaniem, wydajnością i precyzją, możesz podejmować świadome decyzje, które skalują się wraz ze wzrostem Twojej aplikacji.

Konwertuj między formatami znaczników czasu natychmiast

Przełączaj między sekundami, milisekundami i mikrosekundami za pomocą naszego darmowego konwertera znaczników czasu Unix. Nie wymaga kodowania.

Wypróbuj nasze darmowe narzędzie →