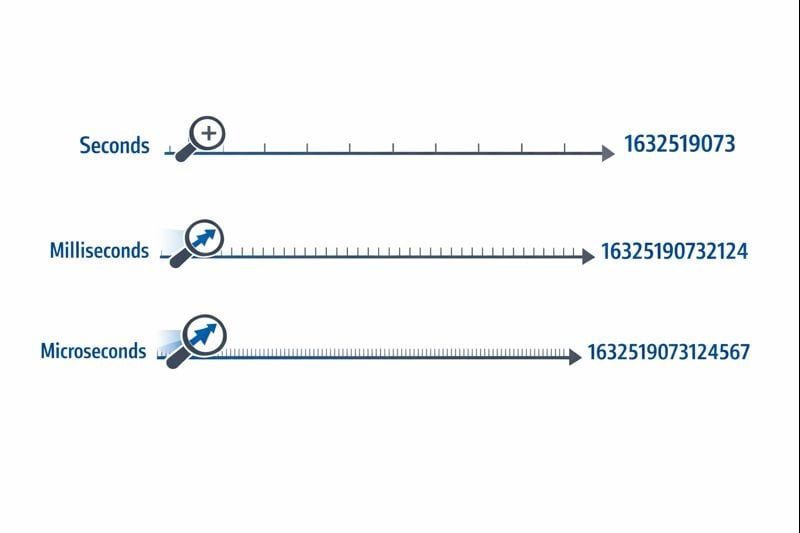

Quando você está trabalhando com timestamps Unix, escolher entre segundos vs milissegundos vs microssegundos pode impactar significativamente o desempenho da sua aplicação, requisitos de armazenamento e precisão. Embora os timestamps Unix tradicionalmente meçam o tempo em segundos desde 1º de janeiro de 1970, aplicações modernas frequentemente exigem maior precisão para registrar eventos, medir tempos de resposta de API ou sincronizar sistemas distribuídos. Este guia detalha as diferenças práticas entre cada nível de precisão e fornece critérios claros para ajudar você a fazer a escolha certa para o seu caso de uso específico.

Índice

Entendendo os Três Níveis de Precisão

Timestamps Unix representam o tempo como um único número contando a partir do ponto de referência epoch time. O nível de precisão determina quão finamente você pode medir intervalos de tempo.

Segundos (10 dígitos): O formato original de timestamp Unix usa um inteiro de 32 bits ou 64 bits representando segundos inteiros. Um valor típico parece 1704067200, que representa exatamente um momento no tempo sem subdivisões.

Milissegundos (13 dígitos): Este formato multiplica o valor em segundos por 1.000, adicionando três casas decimais de precisão. O mesmo momento se torna 1704067200000. A função Date.now() do JavaScript retorna timestamps neste formato por padrão.

Microssegundos (16 dígitos): Usado principalmente em sistemas que requerem precisão extrema, este formato multiplica segundos por 1.000.000. O valor se torna 1704067200000000. Linguagens como time.time_ns() do Python podem trabalhar com precisão de nanossegundos (19 dígitos), embora microssegundos representem o limite superior prático para a maioria das aplicações.

O nível de precisão que você escolhe afeta diretamente o tamanho do seu banco de dados, consumo de memória e desempenho de consultas. Essas restrições se tornam críticas conforme sua aplicação escala.

Requisitos de Armazenamento

Um inteiro de 32 bits (4 bytes) pode armazenar timestamps em segundos até que o problema do Ano 2038 ocorra. A maioria dos sistemas modernos usa inteiros de 64 bits (8 bytes) para evitar essa limitação.

- Segundos: 8 bytes para um inteiro com sinal de 64 bits (BIGINT)

- Milissegundos: 8 bytes para um inteiro com sinal de 64 bits (BIGINT)

- Microssegundos: 8 bytes para um inteiro com sinal de 64 bits (BIGINT)

Embora cada nível de precisão use os mesmos 8 bytes de armazenamento em bancos de dados modernos, o impacto real vem de operações de indexação e consulta. Números maiores requerem mais ciclos de CPU para operações de comparação, e árvores B de índices se tornam ligeiramente menos eficientes com valores de chave maiores.

Desempenho de Consultas no Banco de Dados

Quando você está trabalhando com timestamps Unix em bancos de dados, o nível de precisão afeta consultas de intervalo e operações de ordenação. Um banco de dados comparando números de 10 dígitos tem desempenho marginalmente mais rápido do que comparando números de 16 dígitos, embora a diferença só se torne perceptível com milhões de linhas.

Mais criticamente, misturar níveis de precisão no seu banco de dados cria sobrecarga de conversão. Se sua camada de aplicação envia timestamps em milissegundos mas seu banco de dados armazena em segundos, cada consulta requer divisão por 1.000, impedindo o uso eficiente de índices.

Considerações de Rede e API

Payloads JSON transmitem timestamps como strings ou números. Um timestamp em microssegundos de 16 dígitos adiciona 6 caracteres extras comparado a um timestamp em segundos de 10 dígitos. Ao longo de milhões de chamadas de API, isso adiciona custos mensuráveis de largura de banda e sobrecarga de serialização.

Quando Usar Segundos

Precisão em segundos permanece a melhor escolha para a maioria dos recursos voltados ao usuário onde a percepção humana define a escala de tempo relevante.

Casos de Uso Ideais

- Posts e comentários de redes sociais: Usuários não percebem diferenças abaixo de um segundo

- Tarefas agendadas e cron jobs: A maioria das automações roda em limites de minutos ou horas

- Tokens de autenticação de usuário: Expiração de sessão não requer precisão de sub-segundo

- Datas de publicação de conteúdo: Artigos, vídeos e posts de blog usam precisão em segundos

- Sistemas de reserva e agendamento: Compromissos tipicamente se alinham a slots de minutos ou horas

Passos de Implementação Práticos

Para implementar timestamps em segundos de forma eficaz:

- Use colunas

BIGINTno seu banco de dados para armazenar inteiros com sinal de 64 bits - Crie índices em colunas de timestamp para consultas de intervalo como "posts das últimas 24 horas"

- Em JavaScript, converta timestamps em milissegundos:

Math.floor(Date.now() / 1000) - Em Python, use:

int(time.time()) - Documente sua escolha de precisão nas especificações da API para que os consumidores saibam se devem multiplicar por 1.000

Quando Usar Milissegundos

Precisão em milissegundos se torna necessária quando você precisa rastrear eventos que ocorrem múltiplas vezes por segundo ou medir durações menores que um segundo.

Casos de Uso Ideais

- Monitoramento de tempo de resposta de API: Rastrear se endpoints respondem em 200ms ou 800ms

- Transações financeiras: Registrar a sequência exata de negociações ou etapas de processamento de pagamento

- Mensagens em tempo real: Ordenar mensagens de chat enviadas dentro do mesmo segundo

- Análises de streaming de vídeo: Registrar eventos de reprodução e incidentes de buffering

- Coordenação de sistemas distribuídos: Sincronizar eventos entre múltiplos servidores

Passos de Implementação Práticos

Para implementar timestamps em milissegundos:

- Use colunas

BIGINTno seu banco de dados com documentação clara de que os valores representam milissegundos - Em JavaScript, use

Date.now()diretamente (retorna milissegundos por padrão) - Em Python, use:

int(time.time() * 1000) - Para timestamps do Discord e plataformas similares, milissegundos fornecem a precisão padrão

- Adicione validação em nível de aplicação para garantir que timestamps caiam dentro de intervalos razoáveis (não acidentalmente em segundos ou microssegundos)

Restrições do Mundo Real

Precisão em milissegundos introduz um desafio sutil: nem todos os sistemas geram timestamps em milissegundos verdadeiramente precisos. A resolução do relógio do sistema operacional varia, e ambientes virtualizados podem atualizar seus relógios apenas a cada 10-15 milissegundos. Seus timestamps podem mostrar falsa precisão se o relógio subjacente não suportar precisão real em milissegundos.

Quando Usar Microssegundos

Precisão em microssegundos é excessiva para a maioria das aplicações, mas se torna essencial em domínios especializados que requerem precisão extrema.

Casos de Uso Ideais

- Sistemas de negociação de alta frequência: Registrar atualizações de livro de ordens que ocorrem milhares de vezes por segundo

- Profiling e benchmarking de desempenho: Medir tempos de execução de funções na faixa de microssegundos

- Coleta de dados científicos: Registrar leituras de sensores ou medições experimentais

- Análise de pacotes de rede: Capturar timing exato de eventos de rede para segurança ou debugging

- Processamento de áudio/vídeo: Sincronizar streams multimídia em nível de frame ou amostra

Passos de Implementação Práticos

Para implementar timestamps em microssegundos:

- Verifique se sua linguagem de programação e banco de dados suportam precisão em microssegundos (nem todos suportam)

- Em Python, use:

int(time.time() * 1_000_000) - Em C/C++, use

gettimeofday()ouclock_gettime()comCLOCK_REALTIME - Considere usar bancos de dados de séries temporais especializados como InfluxDB ou TimescaleDB projetados para timestamps de alta precisão

- Documente o requisito de precisão claramente, pois a maioria dos desenvolvedores assumirá milissegundos por padrão

Restrições do Mundo Real

Timestamps em microssegundos criam desafios significativos em sistemas distribuídos. A latência de rede tipicamente se mede em milissegundos, tornando a sincronização em nível de microssegundos entre servidores quase impossível sem hardware especializado como relógios sincronizados por GPS. Se sua aplicação roda em múltiplos data centers, precisão em microssegundos pode fornecer falsa acurácia.

Estudo de Caso: Sistema de Processamento de Pedidos E-commerce

Estudo de Caso Hipotético:

O exemplo a seguir demonstra tomada de decisão do mundo real para precisão de timestamp. Embora a empresa seja fictícia, as restrições técnicas e soluções representam cenários comuns.

ShopFast, uma plataforma de e-commerce de médio porte, inicialmente construiu seu sistema de processamento de pedidos usando timestamps Unix em segundos. Conforme escalaram para processar 500 pedidos por minuto durante horários de pico, encontraram um problema crítico.

O Problema

Múltiplos pedidos feitos dentro do mesmo segundo não podiam ser ordenados de forma confiável. Quando clientes contatavam o suporte perguntando "qual pedido foi processado primeiro?", o sistema não podia fornecer uma resposta definitiva. Mais criticamente, seu sistema de detecção de fraude precisava sinalizar quando o mesmo cartão de crédito era usado para múltiplas compras dentro de uma janela curta, mas a precisão em segundos tornava isso não confiável.

A Análise

A equipe de engenharia avaliou seus requisitos através de diferentes componentes do sistema:

- Timestamps de criação de pedidos: Requeriam precisão em milissegundos para sequenciamento adequado

- Campos last_updated do catálogo de produtos: Precisão em segundos permaneceu suficiente

- Logs de processamento de pagamento: Requeriam precisão em milissegundos para detecção de fraude

- Datas de criação de conta de cliente: Precisão em segundos permaneceu suficiente

- Logging de requisições de API: Requeria precisão em milissegundos para monitoramento de desempenho

A Solução

Em vez de converter todo o banco de dados para milissegundos, implementaram uma abordagem híbrida:

- Migraram

orders.created_atde segundos para milissegundos multiplicando valores existentes por 1.000 - Atualizaram sua camada de API para aceitar e retornar timestamps em milissegundos para endpoints relacionados a pedidos

- Deixaram timestamps voltados ao usuário (criação de conta, último login) em segundos para minimizar o escopo da migração

- Adicionaram documentação clara distinguindo quais campos usavam qual precisão

- Implementaram validação em nível de aplicação para capturar incompatibilidades acidentais de precisão

Os Resultados

Após a migração, o sistema podia sequenciar pedidos de forma confiável e detectar padrões de fraude. O aumento de armazenamento foi negligenciável (adicionando três dígitos aos números existentes), mas a funcionalidade aprimorada justificou o esforço de migração. O desempenho de consultas permaneceu virtualmente idêntico já que mantiveram a indexação adequada.

A lição chave: você não precisa de precisão uniforme em toda a sua aplicação. Escolha o nível apropriado para cada caso de uso específico baseado em requisitos reais, não preocupações teóricas.

Melhores Práticas para Escolher Precisão de Timestamp

Siga estas diretrizes ao implementar timestamps Unix em suas aplicações:

1. Comece com Segundos, Atualize Apenas Quando Necessário

Use precisão em segundos como padrão a menos que você tenha um requisito específico para granularidade mais fina. Otimização prematura desperdiça tempo de desenvolvimento e cria complexidade desnecessária. A maioria das aplicações nunca precisa de precisão sub-segundo.

2. Mantenha Consistência Dentro de Domínios

Use o mesmo nível de precisão para timestamps relacionados. Se sua tabela orders usa milissegundos, suas tabelas order_items e order_payments devem corresponder. Misturar níveis de precisão força conversão constante e cria bugs.

3. Documente Sua Escolha de Precisão

Adicione comentários no seu esquema de banco de dados, documentação de API e código explicando se timestamps representam segundos, milissegundos ou microssegundos. Um valor de timestamp de 1704067200000 é ambíguo sem contexto.

4. Valide Intervalos de Timestamp

Implemente validação para capturar erros de precisão. Um timestamp em segundos deve cair entre aproximadamente 1.000.000.000 (setembro de 2001) e 2.000.000.000 (maio de 2033) para datas atuais. Um timestamp em milissegundos deve ser aproximadamente 1.000 vezes maior. Capturar esses erros cedo previne corrupção de dados.

5. Considere os Tipos Nativos do Seu Banco de Dados

Alguns bancos de dados oferecem tipos nativos de timestamp com precisão embutida. O tipo TIMESTAMP do PostgreSQL armazena precisão em microssegundos internamente. O tipo DATETIME do MySQL suporta microssegundos desde a versão 5.6.4. Esses tipos nativos frequentemente fornecem melhor otimização de consultas do que armazenar inteiros brutos.

6. Considere o Clock Drift em Sistemas Distribuídos

Se você está comparando timestamps gerados por diferentes servidores, até mesmo precisão em milissegundos pode ser enganosa sem sincronização adequada de relógio. Implemente NTP (Network Time Protocol) em todos os servidores e considere usar relógios lógicos (como timestamps de Lamport ou relógios vetoriais) para ordenar eventos em sistemas distribuídos.

7. Teste a Lógica de Conversão Completamente

Ao converter entre níveis de precisão, teste casos extremos como timestamps negativos (datas antes de 1970), timestamps muito grandes (datas muito futuras) e os limites dos seus tipos de inteiros. Um inteiro de 32 bits não pode armazenar timestamps em milissegundos além de 2038.

8. Planeje para o Problema do Ano 2038

Se você está usando timestamps em segundos, garanta que está usando inteiros de 64 bits, não 32 bits. O problema do Ano 2038 afeta apenas inteiros com sinal de 32 bits. Seguir as melhores práticas do tutorial de timestamp Unix ajuda a preparar sua aplicação para o futuro.

Conclusão

Escolher entre segundos vs milissegundos vs microssegundos para timestamps Unix depende dos seus requisitos específicos de aplicação, não de preferências técnicas arbitrárias. Precisão em segundos lida eficientemente com a maioria dos recursos voltados ao usuário, precisão em milissegundos permite monitoramento de API e coordenação em tempo real, e precisão em microssegundos serve aplicações especializadas de alta frequência. Comece com a opção mais simples que atenda suas necessidades, mantenha consistência dentro de dados relacionados e documente suas escolhas claramente. Ao entender as compensações práticas entre armazenamento, desempenho e precisão, você pode tomar decisões informadas que escalam com o crescimento da sua aplicação.

Converta Entre Formatos de Timestamp Instantaneamente

Converta Entre Formatos de Timestamp Instantaneamente

Alterne entre segundos, milissegundos e microssegundos com nosso conversor gratuito de timestamp Unix. Sem necessidade de código.

Experimente Nossa Ferramenta Gratuita →