เมื่อคุณทำงานกับ Unix timestamps การเลือกระหว่าง Seconds vs Milliseconds vs Microseconds สามารถส่งผลกระทบอย่างมีนัยสำคัญต่อประสิทธิภาพของแอปพลิเคชัน ความต้องการในการจัดเก็บข้อมูล และความแม่นยำ แม้ว่า Unix timestamps แบบดั้งเดิมจะวัดเวลาเป็นวินาทีนับตั้งแต่วันที่ 1 มกราคม 1970 แต่แอปพลิเคชันสมัยใหม่มักต้องการความแม่นยำที่สูงขึ้นสำหรับการบันทึกเหตุการณ์ การวัดเวลาตอบสนองของ API หรือการซิงโครไนซ์ระบบแบบกระจาย คู่มือนี้จะอธิบายความแตกต่างทางปฏิบัติระหว่างระดับความแม่นยำแต่ละระดับและให้เกณฑ์ที่ชัดเจนเพื่อช่วยให้คุณเลือกได้อย่างเหมาะสมสำหรับกรณีการใช้งานเฉพาะของคุณ

สารบัญ

ทำความเข้าใจระดับความแม่นยำทั้งสาม

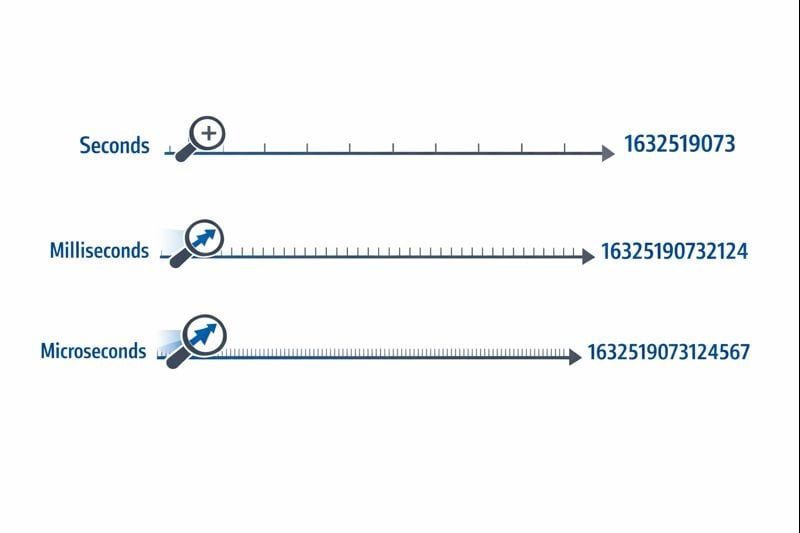

Unix timestamps แสดงเวลาเป็นตัวเลขเดียวที่นับจากจุดอ้างอิง epoch time ระดับความแม่นยำจะกำหนดว่าคุณสามารถวัดช่วงเวลาได้ละเอียดเพียงใด

วินาที (10 หลัก): รูปแบบ Unix timestamp ดั้งเดิมใช้จำนวนเต็ม 32 บิตหรือ 64 บิตที่แสดงถึงวินาทีเต็ม ค่าทั่วไปจะมีลักษณะเช่น 1704067200 ซึ่งแสดงถึงช่วงเวลาหนึ่งโดยไม่มีการแบ่งย่อย

มิลลิวินาที (13 หลัก): รูปแบบนี้คูณค่าวินาทีด้วย 1,000 เพิ่มความแม่นยำทศนิยมสามตำแหน่ง ช่วงเวลาเดียวกันจะกลายเป็น 1704067200000 ฟังก์ชัน Date.now() ของ JavaScript คืนค่า timestamps ในรูปแบบนี้โดยค่าเริ่มต้น

ไมโครวินาที (16 หลัก): ใช้เป็นหลักในระบบที่ต้องการความแม่นยำสูง รูปแบบนี้คูณวินาทีด้วย 1,000,000 ค่าจะกลายเป็น 1704067200000000 ภาษาเช่น time.time_ns() ของ Python สามารถทำงานกับความแม่นยำระดับนาโนวินาที (19 หลัก) แม้ว่าไมโครวินาทีจะเป็นขีดจำกัดบนในทางปฏิบัติสำหรับแอปพลิเคชันส่วนใหญ่

ผลกระทบต่อการจัดเก็บและประสิทธิภาพ

ระดับความแม่นยำที่คุณเลือกส่งผลโดยตรงต่อขนาดฐานข้อมูล การใช้หน่วยความจำ และประสิทธิภาพการสืบค้น ข้อจำกัดเหล่านี้กลายเป็นสิ่งสำคัญเมื่อแอปพลิเคชันของคุณขยายตัว

ความต้องการในการจัดเก็บ

จำนวนเต็ม 32 บิต (4 ไบต์) สามารถเก็บ timestamps ระดับวินาทีได้จนกระทั่งเกิด ปัญหาปี 2038 ระบบสมัยใหม่ส่วนใหญ่ใช้จำนวนเต็ม 64 บิต (8 ไบต์) เพื่อหลีกเลี่ยงข้อจำกัดนี้

- วินาที: 8 ไบต์สำหรับจำนวนเต็มแบบมีเครื่องหมาย 64 บิต (BIGINT)

- มิลลิวินาที: 8 ไบต์สำหรับจำนวนเต็มแบบมีเครื่องหมาย 64 บิต (BIGINT)

- ไมโครวินาที: 8 ไบต์สำหรับจำนวนเต็มแบบมีเครื่องหมาย 64 บิต (BIGINT)

แม้ว่าระดับความแม่นยำแต่ละระดับจะใช้พื้นที่จัดเก็บขนาด 8 ไบต์เท่ากันในฐานข้อมูลสมัยใหม่ แต่ผลกระทบที่แท้จริงเกิดจากการทำดัชนีและการดำเนินการสืบค้น ตัวเลขที่ใหญ่กว่าต้องการรอบ CPU มากขึ้นสำหรับการดำเนินการเปรียบเทียบ และดัชนี B-trees จะมีประสิทธิภาพลดลงเล็กน้อยเมื่อมีค่าคีย์ที่ใหญ่ขึ้น

ประสิทธิภาพการสืบค้นฐานข้อมูล

เมื่อคุณทำงานกับ Unix timestamps ในฐานข้อมูล ระดับความแม่นยำจะส่งผลต่อการสืบค้นช่วงและการดำเนินการเรียงลำดับ ฐานข้อมูลที่เปรียบเทียบตัวเลข 10 หลักจะทำงานได้เร็วกว่าการเปรียบเทียบตัวเลข 16 หลักเล็กน้อย แม้ว่าความแตกต่างจะสังเกตเห็นได้เฉพาะเมื่อมีแถวหลายล้านแถว

ที่สำคัญกว่านั้น การผสมระดับความแม่นยำในฐานข้อมูลของคุณจะสร้างค่าโสหุ้ยในการแปลง หากเลเยอร์แอปพลิเคชันของคุณส่ง timestamps แบบมิลลิวินาทีแต่ฐานข้อมูลของคุณจัดเก็บเป็นวินาที ทุกการสืบค้นจะต้องหารด้วย 1,000 ซึ่งป้องกันการใช้ดัชนีอย่างมีประสิทธิภาพ

ข้อพิจารณาเกี่ยวกับเครือข่ายและ API

เพย์โหลด JSON ส่ง timestamps เป็นสตริงหรือตัวเลข timestamp ไมโครวินาที 16 หลักเพิ่มอักขระพิเศษ 6 ตัวเมื่อเทียบกับ timestamp วินาที 10 หลัก ในการเรียก API หลายล้านครั้ง สิ่งนี้เพิ่มต้นทุนแบนด์วิดท์และค่าโสหุ้ยในการแปลงรูปแบบข้อมูลที่วัดได้

เมื่อไรควรใช้วินาที

ความแม่นยำระดับวินาทียังคงเป็นตัวเลือกที่ดีที่สุดสำหรับฟีเจอร์ส่วนใหญ่ที่ผู้ใช้มองเห็น ซึ่งการรับรู้ของมนุษย์กำหนดระดับเวลาที่เกี่ยวข้อง

กรณีการใช้งานที่เหมาะสม

- โพสต์และความคิดเห็นในโซเชียลมีเดีย: ผู้ใช้ไม่รับรู้ความแตกต่างที่น้อยกว่าหนึ่งวินาที

- งานที่กำหนดเวลาและ cron jobs: ระบบอัตโนมัติส่วนใหญ่ทำงานในขอบเขตของนาทีหรือชั่วโมง

- โทเค็นการตรวจสอบสิทธิ์ผู้ใช้: การหมดอายุของเซสชันไม่จำเป็นต้องมีความแม่นยำระดับต่ำกว่าวินาที

- วันที่เผยแพร่เนื้อหา: บทความ วิดีโอ และบล็อกโพสต์ใช้ความแม่นยำระดับวินาที

- ระบบการจองและการสำรองที่นั่ง: การนัดหมายมักจะเรียงตามช่วงเวลานาทีหรือชั่วโมง

ขั้นตอนการนำไปใช้

การนำ timestamps ระดับวินาทีไปใช้อย่างมีประสิทธิภาพ:

- ใช้คอลัมน์

BIGINTในฐานข้อมูลของคุณเพื่อเก็บจำนวนเต็มแบบมีเครื่องหมาย 64 บิต - สร้างดัชนีบนคอลัมน์ timestamp สำหรับการสืบค้นช่วงเช่น "โพสต์จาก 24 ชั่วโมงที่ผ่านมา"

- ใน JavaScript แปลง timestamps มิลลิวินาที:

Math.floor(Date.now() / 1000) - ใน Python ใช้:

int(time.time()) - จัดทำเอกสารการเลือกความแม่นยำของคุณในข้อกำหนด API เพื่อให้ผู้บริโภคทราบว่าต้องคูณด้วย 1,000 หรือไม่

เมื่อไรควรใช้มิลลิวินาที

ความแม่นยำระดับมิลลิวินาทีจำเป็นเมื่อคุณต้องการติดตามเหตุการณ์ที่เกิดขึ้นหลายครั้งต่อวินาทีหรือวัดระยะเวลาที่สั้นกว่าหนึ่งวินาที

กรณีการใช้งานที่เหมาะสม

- การตรวจสอบเวลาตอบสนองของ API: การติดตามว่า endpoints ตอบสนองภายใน 200ms หรือ 800ms

- ธุรกรรมทางการเงิน: การบันทึกลำดับที่แน่นอนของการซื้อขายหรือขั้นตอนการประมวลผลการชำระเงิน

- การส่งข้อความแบบเรียลไทม์: การจัดลำดับข้อความแชทที่ส่งภายในวินาทีเดียวกัน

- การวิเคราะห์การสตรีมวิดีโอ: การบันทึกเหตุการณ์การเล่นและเหตุการณ์การบัฟเฟอร์

- การประสานงานระบบแบบกระจาย: การซิงโครไนซ์เหตุการณ์ระหว่างเซิร์ฟเวอร์หลายเครื่อง

ขั้นตอนการนำไปใช้

การนำ timestamps ระดับมิลลิวินาทีไปใช้:

- ใช้คอลัมน์

BIGINTในฐานข้อมูลของคุณพร้อมเอกสารที่ชัดเจนว่าค่าแสดงถึงมิลลิวินาที - ใน JavaScript ใช้

Date.now()โดยตรง (คืนค่ามิลลิวินาทีโดยค่าเริ่มต้น) - ใน Python ใช้:

int(time.time() * 1000) - สำหรับ Discord timestamps และแพลตฟอร์มที่คล้ายกัน มิลลิวินาทีให้ความแม่นยำมาตรฐาน

- เพิ่มการตรวจสอบระดับแอปพลิเคชันเพื่อให้แน่ใจว่า timestamps อยู่ในช่วงที่เหมาะสม (ไม่ได้อยู่ในวินาทีหรือไมโครวินาทีโดยบังเอิญ)

ข้อจำกัดในโลกแห่งความเป็นจริง

ความแม่นยำระดับมิลลิวินาทีมีความท้าทายที่ซับซ้อน: ไม่ใช่ทุกระบบที่สร้าง timestamps มิลลิวินาทีที่แม่นยำจริงๆ ความละเอียดของนาฬิการะบบปฏิบัติการมีความแตกต่างกัน และสภาพแวดล้อมเสมือนอาจอัปเดตนาฬิกาทุก 10-15 มิลลิวินาทีเท่านั้น timestamps ของคุณอาจแสดงความแม่นยำที่ไม่ถูกต้องหากนาฬิกาพื้นฐานไม่รองรับความแม่นยำระดับมิลลิวินาทีที่แท้จริง

เมื่อไรควรใช้ไมโครวินาที

ความแม่นยำระดับไมโครวินาทีเกินความจำเป็นสำหรับแอปพลิเคชันส่วนใหญ่ แต่กลายเป็นสิ่งจำเป็นในโดเมนเฉพาะทางที่ต้องการความแม่นยำสูงมาก

กรณีการใช้งานที่เหมาะสม

- ระบบการซื้อขายความถี่สูง: การบันทึกการอัปเดตสมุดคำสั่งซื้อที่เกิดขึ้นหลายพันครั้งต่อวินาที

- การวัดประสิทธิภาพและการทดสอบเกณฑ์มาตรฐาน: การวัดเวลาการทำงานของฟังก์ชันในช่วงไมโครวินาที

- การเก็บข้อมูลทางวิทยาศาสตร์: การบันทึกค่าจากเซ็นเซอร์หรือการวัดการทดลอง

- การวิเคราะห์แพ็คเก็ตเครือข่าย: การบันทึกเวลาที่แน่นอนของเหตุการณ์เครือข่ายเพื่อความปลอดภัยหรือการแก้ไขข้อบกพร่อง

- การประมวลผลเสียง/วิดีโอ: การซิงโครไนซ์สตรีมมัลติมีเดียในระดับเฟรมหรือตัวอย่าง

ขั้นตอนการนำไปใช้

การนำ timestamps ระดับไมโครวินาทีไปใช้:

- ตรวจสอบว่าภาษาโปรแกรมและฐานข้อมูลของคุณรองรับความแม่นยำระดับไมโครวินาที (ไม่ใช่ทั้งหมดที่รองรับ)

- ใน Python ใช้:

int(time.time() * 1_000_000) - ใน C/C++ ใช้

gettimeofday()หรือclock_gettime()กับCLOCK_REALTIME - พิจารณาใช้ฐานข้อมูลอนุกรมเวลาเฉพาะทางเช่น InfluxDB หรือ TimescaleDB ที่ออกแบบมาสำหรับ timestamps ที่มีความแม่นยำสูง

- จัดทำเอกสารข้อกำหนดความแม่นยำให้ชัดเจน เนื่องจากนักพัฒนาส่วนใหญ่จะสันนิษฐานว่าเป็นมิลลิวินาทีโดยค่าเริ่มต้น

ข้อจำกัดในโลกแห่งความเป็นจริง

Timestamps ไมโครวินาทีสร้างความท้าทายที่สำคัญในระบบแบบกระจาย ความล่าช้าของเครือข่ายโดยทั่วไปวัดเป็นมิลลิวินาที ทำให้การซิงโครไนซ์ระดับไมโครวินาทีระหว่างเซิร์ฟเวอร์เป็นไปไม่ได้เกือบจะโดยสิ้นเชิงโดยไม่มีฮาร์ดแวร์เฉพาะทางเช่นนาฬิกาที่ซิงโครไนซ์ด้วย GPS หากแอปพลิเคชันของคุณทำงานในศูนย์ข้อมูลหลายแห่ง ความแม่นยำระดับไมโครวินาทีอาจให้ความแม่นยำที่ไม่ถูกต้อง

กรณีศึกษา: ระบบประมวลผลคำสั่งซื้อ E-commerce

กรณีศึกษาสมมติ:

ตัวอย่างต่อไปนี้แสดงการตัดสินใจในโลกแห่งความเป็นจริงสำหรับความแม่นยำของ timestamp แม้ว่าบริษัทจะเป็นเรื่องสมมติ แต่ข้อจำกัดทางเทคนิคและวิธีแก้ปัญหาเป็นตัวแทนของสถานการณ์ทั่วไป

ShopFast แพลตฟอร์ม e-commerce ขนาดกลาง เริ่มต้นสร้างระบบประมวลผลคำสั่งซื้อโดยใช้ Unix timestamps ระดับวินาที เมื่อพวกเขาขยายตัวถึงการประมวลผล 500 คำสั่งซื้อต่อนาทีในช่วงเวลาที่มีการใช้งานสูงสุด พวกเขาประสบปัญหาสำคัญ

ปัญหา

คำสั่งซื้อหลายรายการที่สั่งภายในวินาทีเดียวกันไม่สามารถเรียงลำดับได้อย่างน่าเชื่อถือ เมื่อลูกค้าติดต่อฝ่ายสนับสนุนและถามว่า "คำสั่งซื้อไหนเสร็จก่อน" ระบบไม่สามารถให้คำตอบที่แน่นอนได้ ที่สำคัญกว่านั้น ระบบตรวจจับการฉ้อโกงของพวกเขาจำเป็นต้องแจ้งเตือนเมื่อบัตรเครดิตเดียวกันถูกใช้สำหรับการซื้อหลายครั้งภายในช่วงเวลาสั้นๆ แต่ความแม่นยำระดับวินาทีทำให้สิ่งนี้ไม่น่าเชื่อถือ

การวิเคราะห์

ทีมวิศวกรประเมินความต้องการในส่วนประกอบต่างๆ ของระบบ:

- Timestamps การสร้างคำสั่งซื้อ: ต้องการความแม่นยำระดับมิลลิวินาทีสำหรับการลำดับที่เหมาะสม

- ฟิลด์ last_updated ของแคตตาล็อกสินค้า: ความแม่นยำระดับวินาทียังคงเพียงพอ

- บันทึกการประมวลผลการชำระเงิน: ต้องการความแม่นยำระดับมิลลิวินาทีสำหรับการตรวจจับการฉ้อโกง

- วันที่สร้างบัญชีลูกค้า: ความแม่นยำระดับวินาทียังคงเพียงพอ

- การบันทึกการร้องขอ API: ต้องการความแม่นยำระดับมิลลิวินาทีสำหรับการตรวจสอบประสิทธิภาพ

วิธีแก้ปัญหา

แทนที่จะแปลงฐานข้อมูลทั้งหมดเป็นมิลลิวินาที พวกเขาได้นำวิธีการแบบผสมผสานมาใช้:

- ย้าย

orders.created_atจากวินาทีเป็นมิลลิวินาทีโดยคูณค่าที่มีอยู่ด้วย 1,000 - อัปเดตเลเยอร์ API ให้ยอมรับและส่งคืน timestamps มิลลิวินาทีสำหรับ endpoints ที่เกี่ยวข้องกับคำสั่งซื้อ

- ปล่อย timestamps ที่ผู้ใช้มองเห็น (การสร้างบัญชี, การเข้าสู่ระบบล่าสุด) ในวินาทีเพื่อลดขอบเขตการย้าย

- เพิ่มเอกสารที่ชัดเจนแยกแยะว่าฟิลด์ใดใช้ความแม่นยำแบบใด

- นำการตรวจสอบระดับแอปพลิเคชันมาใช้เพื่อตรวจจับความไม่ตรงกันของความแม่นยำโดยไม่ได้ตั้งใจ

ผลลัพธ์

หลังจากการย้าย ระบบสามารถลำดับคำสั่งซื้อและตรวจจับรูปแบบการฉ้อโกงได้อย่างน่าเชื่อถือ การเพิ่มพื้นที่จัดเก็บนั้นน้อยมาก (เพิ่มสามหลักให้กับตัวเลขที่มีอยู่) แต่ฟังก์ชันการทำงานที่ดีขึ้นรองรับความพยายามในการย้าย ประสิทธิภาพการสืบค้นยังคงเหมือนเดิมเนื่องจากพวกเขารักษาการทำดัชนีที่เหมาะสม

บทเรียนสำคัญ: คุณไม่จำเป็นต้องมีความแม่นยำที่เหมือนกันทั่วทั้งแอปพลิเคชัน เลือกระดับที่เหมาะสมสำหรับกรณีการใช้งานเฉพาะแต่ละกรณีตามความต้องการจริง ไม่ใช่ข้อกังวลเชิงทฤษฎี

แนวทางปฏิบัติที่ดีที่สุดในการเลือกความแม่นยำของ Timestamp

ปฏิบัติตามแนวทางเหล่านี้เมื่อนำ Unix timestamps ไปใช้ในแอปพลิเคชันของคุณ:

1. เริ่มต้นด้วยวินาที อัพเกรดเมื่อจำเป็นเท่านั้น

ใช้ความแม่นยำระดับวินาทีเป็นค่าเริ่มต้นเว้นแต่คุณจะมีข้อกำหนดเฉพาะสำหรับความละเอียดที่ดีกว่า การเพิ่มประสิทธิภาพก่อนเวลาอันควรเป็นการเสียเวลาในการพัฒนาและสร้างความซับซ้อนที่ไม่จำเป็น แอปพลิเคชันส่วนใหญ่ไม่จำเป็นต้องมีความแม่นยำระดับต่ำกว่าวินาที

2. รักษาความสอดคล้องภายในโดเมน

ใช้ระดับความแม่นยำเดียวกันสำหรับ timestamps ที่เกี่ยวข้องกัน หากตาราง orders ของคุณใช้มิลลิวินาที ตาราง order_items และ order_payments ควรตรงกัน การผสมระดับความแม่นยำบังคับให้ต้องแปลงอยู่ตลอดเวลาและสร้างข้อบกพร่อง

3. จัดทำเอกสารการเลือกความแม่นยำของคุณ

เพิ่มความคิดเห็นในสคีมาฐานข้อมูล เอกสาร API และโค้ดที่อธิบายว่า timestamps แสดงถึงวินาที มิลลิวินาที หรือไมโครวินาที ค่า timestamp 1704067200000 มีความคลุมเครือหากไม่มีบริบท

4. ตรวจสอบช่วงของ Timestamp

นำการตรวจสอบมาใช้เพื่อตรวจจับข้อผิดพลาดความแม่นยำ timestamp ในวินาทีควรอยู่ระหว่