Khi bạn làm việc với Unix timestamp, việc lựa chọn giữa seconds vs milliseconds vs microseconds có thể ảnh hưởng đáng kể đến hiệu suất ứng dụng, yêu cầu lưu trữ và độ chính xác. Mặc dù Unix timestamp truyền thống đo thời gian bằng giây kể từ ngày 1 tháng 1 năm 1970, các ứng dụng hiện đại thường yêu cầu độ chính xác cao hơn để ghi log sự kiện, đo thời gian phản hồi API hoặc đồng bộ hóa hệ thống phân tán. Hướng dẫn này phân tích các khác biệt thực tế giữa từng mức độ chính xác và cung cấp tiêu chí rõ ràng để giúp bạn đưa ra lựa chọn phù hợp cho trường hợp sử dụng cụ thể của mình.

Mục Lục

Hiểu Về Ba Mức Độ Chính Xác

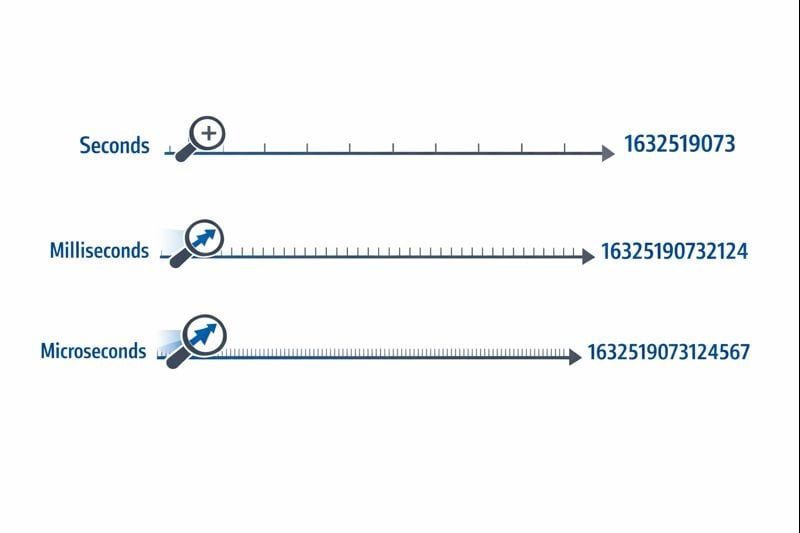

Unix timestamp biểu diễn thời gian dưới dạng một số duy nhất đếm từ điểm tham chiếu epoch time. Mức độ chính xác xác định mức độ chi tiết bạn có thể đo khoảng thời gian.

Seconds (10 chữ số): Định dạng Unix timestamp gốc sử dụng số nguyên 32-bit hoặc 64-bit biểu diễn số giây nguyên. Một giá trị điển hình trông như 1704067200, đại diện cho chính xác một thời điểm mà không có phân chia nhỏ hơn.

Milliseconds (13 chữ số): Định dạng này nhân giá trị giây với 1.000, thêm ba chữ số thập phân về độ chính xác. Cùng một thời điểm trở thành 1704067200000. Hàm Date.now() của JavaScript trả về timestamp ở định dạng này theo mặc định.

Microseconds (16 chữ số): Được sử dụng chủ yếu trong các hệ thống yêu cầu độ chính xác cực cao, định dạng này nhân giây với 1.000.000. Giá trị trở thành 1704067200000000. Các ngôn ngữ như time.time_ns() của Python có thể làm việc với độ chính xác nanosecond (19 chữ số), mặc dù microseconds đại diện cho giới hạn trên thực tế cho hầu hết các ứng dụng.

Ảnh Hưởng Về Lưu Trữ Và Hiệu Suất

Mức độ chính xác bạn chọn ảnh hưởng trực tiếp đến kích thước cơ sở dữ liệu, mức tiêu thụ bộ nhớ và hiệu suất truy vấn. Những ràng buộc này trở nên quan trọng khi ứng dụng của bạn mở rộng quy mô.

Yêu Cầu Lưu Trữ

Một số nguyên 32-bit (4 byte) có thể lưu trữ timestamp cấp giây cho đến khi xảy ra vấn đề Year 2038. Hầu hết các hệ thống hiện đại sử dụng số nguyên 64-bit (8 byte) để tránh hạn chế này.

- Seconds: 8 byte cho số nguyên 64-bit có dấu (BIGINT)

- Milliseconds: 8 byte cho số nguyên 64-bit có dấu (BIGINT)

- Microseconds: 8 byte cho số nguyên 64-bit có dấu (BIGINT)

Mặc dù mỗi mức độ chính xác sử dụng cùng dung lượng lưu trữ 8 byte trong cơ sở dữ liệu hiện đại, tác động thực sự đến từ các hoạt động đánh index và truy vấn. Số lớn hơn yêu cầu nhiều chu kỳ CPU hơn cho các phép so sánh, và cây B-tree của index trở nên kém hiệu quả hơn một chút với các giá trị khóa lớn hơn.

Hiệu Suất Truy Vấn Cơ Sở Dữ Liệu

Khi bạn làm việc với Unix timestamp trong cơ sở dữ liệu, mức độ chính xác ảnh hưởng đến các truy vấn phạm vi và các hoạt động sắp xếp. Cơ sở dữ liệu so sánh các số 10 chữ số nhanh hơn một chút so với so sánh các số 16 chữ số, mặc dù sự khác biệt chỉ trở nên đáng chú ý ở hàng triệu hàng.

Quan trọng hơn, việc trộn lẫn các mức độ chính xác trong cơ sở dữ liệu của bạn tạo ra chi phí chuyển đổi. Nếu lớp ứng dụng của bạn gửi timestamp millisecond nhưng cơ sở dữ liệu lưu trữ seconds, mỗi truy vấn yêu cầu chia cho 1.000, ngăn cản việc sử dụng index hiệu quả.

Cân Nhắc Về Mạng Và API

Các payload JSON truyền timestamp dưới dạng chuỗi hoặc số. Một timestamp microsecond 16 chữ số thêm 6 ký tự so với timestamp second 10 chữ số. Qua hàng triệu lần gọi API, điều này tạo ra chi phí băng thông và overhead serialization đáng kể.

Khi Nào Sử Dụng Seconds

Độ chính xác cấp giây vẫn là lựa chọn tốt nhất cho hầu hết các tính năng hướng đến người dùng, nơi nhận thức của con người xác định thang thời gian liên quan.

Các Trường Hợp Sử Dụng Lý Tưởng

- Bài đăng và bình luận trên mạng xã hội: Người dùng không nhận thấy sự khác biệt dưới một giây

- Tác vụ theo lịch và cron job: Hầu hết tự động hóa chạy theo ranh giới phút hoặc giờ

- Token xác thực người dùng: Thời hạn session không yêu cầu độ chính xác dưới giây

- Ngày xuất bản nội dung: Bài viết, video và blog sử dụng độ chính xác cấp giây

- Hệ thống đặt chỗ và đặt phòng: Các cuộc hẹn thường căn chỉnh theo khe phút hoặc giờ

Các Bước Triển Khai Thực Tế

Để triển khai timestamp cấp giây hiệu quả:

- Sử dụng cột

BIGINTtrong cơ sở dữ liệu để lưu trữ số nguyên 64-bit có dấu - Tạo index trên các cột timestamp cho các truy vấn phạm vi như "bài đăng từ 24 giờ qua"

- Trong JavaScript, chuyển đổi timestamp millisecond:

Math.floor(Date.now() / 1000) - Trong Python, sử dụng:

int(time.time()) - Ghi chép lựa chọn độ chính xác của bạn trong đặc tả API để người sử dụng biết có cần nhân với 1.000 hay không

Khi Nào Sử Dụng Milliseconds

Độ chính xác millisecond trở nên cần thiết khi bạn cần theo dõi các sự kiện xảy ra nhiều lần mỗi giây hoặc đo khoảng thời gian ngắn hơn một giây.

Các Trường Hợp Sử Dụng Lý Tưởng

- Giám sát thời gian phản hồi API: Theo dõi xem các endpoint phản hồi trong vòng 200ms hay 800ms

- Giao dịch tài chính: Ghi lại chuỗi chính xác các giao dịch hoặc bước xử lý thanh toán

- Nhắn tin thời gian thực: Sắp xếp tin nhắn chat được gửi trong cùng một giây

- Phân tích streaming video: Ghi lại các sự kiện phát lại và sự cố buffering

- Phối hợp hệ thống phân tán: Đồng bộ hóa các sự kiện trên nhiều máy chủ

Các Bước Triển Khai Thực Tế

Để triển khai timestamp cấp millisecond:

- Sử dụng cột

BIGINTtrong cơ sở dữ liệu với tài liệu rõ ràng rằng giá trị đại diện cho milliseconds - Trong JavaScript, sử dụng

Date.now()trực tiếp (nó trả về milliseconds theo mặc định) - Trong Python, sử dụng:

int(time.time() * 1000) - Đối với Discord timestamp và các nền tảng tương tự, milliseconds cung cấp độ chính xác tiêu chuẩn

- Thêm validation cấp ứng dụng để đảm bảo timestamp nằm trong phạm vi hợp lý (không vô tình ở dạng seconds hoặc microseconds)

Ràng Buộc Thực Tế

Độ chính xác millisecond đưa ra một thách thức tinh tế: không phải tất cả các hệ thống đều tạo ra timestamp millisecond thực sự chính xác. Độ phân giải đồng hồ hệ điều hành khác nhau, và môi trường ảo hóa có thể chỉ cập nhật đồng hồ của chúng mỗi 10-15 milliseconds. Timestamp của bạn có thể hiển thị độ chính xác giả nếu đồng hồ cơ bản không hỗ trợ độ chính xác millisecond thực sự.

Khi Nào Sử Dụng Microseconds

Độ chính xác microsecond là quá mức cho hầu hết các ứng dụng nhưng trở nên thiết yếu trong các lĩnh vực chuyên biệt yêu cầu độ chính xác cực cao.

Các Trường Hợp Sử Dụng Lý Tưởng

- Hệ thống giao dịch tần số cao: Ghi lại cập nhật sổ lệnh xảy ra hàng nghìn lần mỗi giây

- Profiling hiệu suất và benchmarking: Đo thời gian thực thi hàm trong phạm vi microsecond

- Thu thập dữ liệu khoa học: Ghi log các số đọc cảm biến hoặc đo lường thí nghiệm

- Phân tích gói mạng: Ghi lại thời gian chính xác của các sự kiện mạng cho bảo mật hoặc debug

- Xử lý âm thanh/video: Đồng bộ hóa các luồng đa phương tiện ở cấp độ khung hình hoặc mẫu

Các Bước Triển Khai Thực Tế

Để triển khai timestamp cấp microsecond:

- Xác minh ngôn ngữ lập trình và cơ sở dữ liệu của bạn hỗ trợ độ chính xác microsecond (không phải tất cả đều hỗ trợ)

- Trong Python, sử dụng:

int(time.time() * 1_000_000) - Trong C/C++, sử dụng

gettimeofday()hoặcclock_gettime()vớiCLOCK_REALTIME - Cân nhắc sử dụng cơ sở dữ liệu time-series chuyên biệt như InfluxDB hoặc TimescaleDB được thiết kế cho timestamp độ chính xác cao

- Ghi chép rõ ràng yêu cầu độ chính xác, vì hầu hết các developer sẽ giả định milliseconds theo mặc định

Ràng Buộc Thực Tế

Timestamp microsecond tạo ra những thách thức đáng kể trong hệ thống phân tán. Độ trễ mạng thường đo bằng milliseconds, khiến việc đồng bộ hóa cấp microsecond trên các máy chủ gần như không thể mà không có phần cứng chuyên biệt như đồng hồ đồng bộ GPS. Nếu ứng dụng của bạn chạy trên nhiều trung tâm dữ liệu, độ chính xác microsecond có thể cung cấp độ chính xác giả.

Nghiên Cứu Tình Huống: Hệ Thống Xử Lý Đơn Hàng E-commerce

Nghiên Cứu Tình Huống Giả Định:

Ví dụ sau đây minh họa quá trình ra quyết định thực tế cho độ chính xác timestamp. Mặc dù công ty là hư cấu, các ràng buộc kỹ thuật và giải pháp đại diện cho các tình huống phổ biến.

ShopFast, một nền tảng thương mại điện tử cỡ trung bình, ban đầu xây dựng hệ thống xử lý đơn hàng của họ bằng Unix timestamp cấp giây. Khi họ mở rộng quy mô để xử lý 500 đơn hàng mỗi phút trong giờ cao điểm, họ gặp phải một vấn đề nghiêm trọng.

Vấn Đề

Nhiều đơn hàng được đặt trong cùng một giây không thể được sắp xếp một cách đáng tin cậy. Khi khách hàng liên hệ với bộ phận hỗ trợ hỏi "đơn hàng nào được xử lý trước?", hệ thống không thể cung cấp câu trả lời chắc chắn. Quan trọng hơn, hệ thống phát hiện gian lận của họ cần gắn cờ khi cùng một thẻ tín dụng được sử dụng cho nhiều giao dịch mua trong một khoảng thời gian ngắn, nhưng độ chính xác cấp giây khiến điều này không đáng tin cậy.

Phân Tích

Nhóm kỹ thuật đánh giá yêu cầu của họ trên các thành phần hệ thống khác nhau:

- Timestamp tạo đơn hàng: Yêu cầu độ chính xác millisecond để sắp xếp đúng

- Trường last_updated của catalog sản phẩm: Độ chính xác second vẫn đủ

- Log xử lý thanh toán: Yêu cầu độ chính xác millisecond để phát hiện gian lận

- Ngày tạo tài khoản khách hàng: Độ chính xác second vẫn đủ

- Logging request API: Yêu cầu độ chính xác millisecond để giám sát hiệu suất

Giải Pháp

Thay vì chuyển đổi toàn bộ cơ sở dữ liệu sang milliseconds, họ triển khai cách tiếp cận kết hợp:

- Di chuyển

orders.created_attừ seconds sang milliseconds bằng cách nhân các giá trị hiện có với 1.000 - Cập nhật lớp API của họ để chấp nhận và trả về timestamp millisecond cho các endpoint liên quan đến đơn hàng

- Để nguyên timestamp hướng đến người dùng (tạo tài khoản, đăng nhập lần cuối) ở dạng seconds để giảm thiểu phạm vi di chuyển

- Thêm tài liệu rõ ràng phân biệt trường nào sử dụng độ chính xác nào

- Triển khai validation cấp ứng dụng để phát hiện sự không khớp độ chính xác vô tình

Kết Quả

Sau khi di chuyển, hệ thống có thể sắp xếp đơn hàng một cách đáng tin cậy và phát hiện các mẫu gian lận. Sự gia tăng lưu trữ là không đáng kể (thêm ba chữ số vào các số hiện có), nhưng chức năng được cải thiện biện minh cho nỗ lực di chuyển. Hiệu suất truy vấn vẫn gần như giống hệt vì họ duy trì indexing phù hợp.

Bài học chính: bạn không cần độ chính xác đồng nhất trên toàn bộ ứng dụng của mình. Chọn mức độ phù hợp cho từng trường hợp sử dụng cụ thể dựa trên yêu cầu thực tế, không phải mối quan tâm lý thuyết.

Thực Hành Tốt Nhất Khi Chọn Độ Chính Xác Timestamp

Tuân theo các hướng dẫn này khi triển khai Unix timestamp trong ứng dụng của bạn:

1. Bắt Đầu Với Seconds, Chỉ Nâng Cấp Khi Cần Thiết

Mặc định sử dụng độ chính xác cấp giây trừ khi bạn có yêu cầu cụ thể cho độ chi tiết mịn hơn. Tối ưu hóa sớm lãng phí thời gian phát triển và tạo ra sự phức tạp không cần thiết. Hầu hết các ứng dụng không bao giờ cần độ chính xác dưới giây.

2. Duy Trì Tính Nhất Quán Trong Các Domain

Sử dụng cùng mức độ chính xác cho các timestamp liên quan. Nếu bảng orders của bạn sử dụng milliseconds, các bảng order_items và order_payments nên khớp. Trộn lẫn các mức độ chính xác buộc phải chuyển đổi liên tục và tạo ra lỗi.

3. Ghi Chép Lựa Chọn Độ Chính Xác Của Bạn

Thêm bình luận trong schema cơ sở dữ liệu, tài liệu API và code giải thích liệu timestamp đại diện cho seconds, milliseconds hay microseconds. Giá trị timestamp 1704067200000 là mơ hồ nếu không có ngữ cảnh.

4. Validate Phạm Vi Timestamp

Triển khai validation để phát hiện lỗi độ chính xác. Một timestamp ở dạng seconds nên nằm trong khoảng từ khoảng 1.000.000.000 (tháng 9/2001) đến 2.000.000.000 (tháng 5/2033) cho ngày hiện tại. Một timestamp millisecond nên lớn hơn khoảng 1.000 lần. Phát hiện những lỗi này sớm ngăn ngừa hỏng dữ liệu.

5. Cân Nhắc Các Kiểu Dữ Liệu Native Của Cơ Sở Dữ Liệu

Một số cơ sở dữ liệu cung cấp các kiểu timestamp native với độ chính xác tích hợp. Kiểu TIMESTAMP của PostgreSQL lưu trữ độ chính xác microsecond bên trong. Kiểu DATETIME của MySQL hỗ trợ microseconds từ phiên bản 5.6.4. Những kiểu native này thường cung cấp tối ưu hóa truy vấn tốt hơn so với lưu trữ số nguyên thô.

6. Tính Đến Clock Drift Trong Hệ Thống Phân Tán

Nếu bạn đang so sánh timestamp được tạo bởi các máy chủ khác nhau, ngay cả độ chính xác millisecond cũng có thể gây hiểu lầm nếu không có đồng bộ hóa đồng hồ phù hợp. Triển khai NTP (Network Time Protocol) trên tất cả các máy chủ và cân nhắc sử dụng đồng hồ logic (như Lamport timestamp hoặc vector clock) để sắp xếp các sự kiện trong hệ thống phân tán.

7. Kiểm Tra Logic Chuyển Đổi Kỹ Lưỡng

Khi chuyển đổi giữa các mức độ chính xác, kiểm tra các trường hợp biên như timestamp âm (ngày trước 1970), timestamp rất lớn (ngày trong tương lai xa) và ranh giới của các kiểu số nguyên. Một số nguyên 32-bit không thể lưu trữ timestamp millisecond vượt quá năm 2038.

8. Lập Kế Hoạch Cho Vấn Đề Year 2038

Nếu bạn đang sử dụng timestamp cấp giây, hãy đảm bảo bạn đang sử dụng số nguyên 64-bit, không phải 32-bit. Vấn đề Year 2038 chỉ ảnh hưởng đến số nguyên có dấu 32-bit. Tuân theo thực hành tốt nhất của hướng dẫn Unix timestamp giúp ứng dụng của bạn bền vững trong tương lai.

Kết Luận

Lựa chọn giữa seconds vs milliseconds vs microseconds cho Unix timestamp phụ thuộc vào yêu cầu ứng dụng cụ thể của bạn, không phải sở thích kỹ thuật tùy ý. Độ chính xác cấp giây xử lý hầu hết các tính năng hướng đến người dùng một cách hiệu quả, độ chính xác millisecond cho phép giám sát API và phối hợp thời gian thực, và độ chính xác microsecond phục vụ các ứng dụng tần số cao chuyên biệt. Bắt đầu với tùy chọn đơn giản nhất đáp ứng nhu cầu của bạn, duy trì tính nhất quán trong dữ liệu liên quan và ghi chép lựa chọn của bạn rõ ràng. Bằng cách hiểu các đánh đổi thực tế giữa lưu trữ, hiệu suất và độ chính xác, bạn có thể đưa ra quyết định sáng suốt mở rộng cùng với sự phát triển của ứng dụng.

Chuyển Đổi Giữa Các Định Dạng Timestamp Ngay Lập Tức

Chuyển đổi giữa seconds, milliseconds và microseconds với công cụ chuyển đổi Unix timestamp miễn phí của chúng tôi. Không cần code.

Dùng Thử Công Cụ Miễn Phí →