Cuando trabajas con timestamps de Unix, elegir entre segundos vs milisegundos vs microsegundos puede impactar significativamente el rendimiento de tu aplicación, los requisitos de almacenamiento y la precisión. Aunque los timestamps de Unix tradicionalmente miden el tiempo en segundos desde el 1 de enero de 1970, las aplicaciones modernas a menudo demandan mayor precisión para registrar eventos, medir tiempos de respuesta de APIs o sincronizar sistemas distribuidos. Esta guía desglosa las diferencias prácticas entre cada nivel de precisión y proporciona criterios claros para ayudarte a tomar la decisión correcta según tu caso de uso específico.

Tabla de Contenidos

Entendiendo los Tres Niveles de Precisión

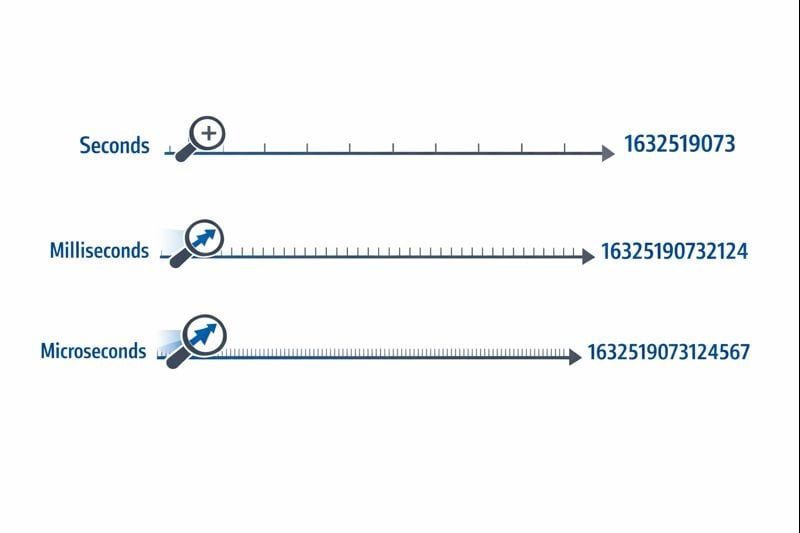

Los timestamps de Unix representan el tiempo como un solo número contando desde el punto de referencia del tiempo epoch. El nivel de precisión determina cuán finamente puedes medir intervalos de tiempo.

Segundos (10 dígitos): El formato original de timestamp de Unix usa un entero de 32 o 64 bits que representa segundos completos. Un valor típico se ve como 1704067200, que representa exactamente un momento en el tiempo sin subdivisiones.

Milisegundos (13 dígitos): Este formato multiplica el valor de segundos por 1,000, agregando tres lugares decimales de precisión. El mismo momento se convierte en 1704067200000. La función Date.now() de JavaScript devuelve timestamps en este formato por defecto.

Microsegundos (16 dígitos): Usado principalmente en sistemas que requieren precisión extrema, este formato multiplica los segundos por 1,000,000. El valor se convierte en 1704067200000000. Lenguajes como time.time_ns() de Python pueden trabajar incluso con precisión de nanosegundos (19 dígitos), aunque los microsegundos representan el límite superior práctico para la mayoría de aplicaciones.

El nivel de precisión que elijas afecta directamente el tamaño de tu base de datos, el consumo de memoria y el rendimiento de las consultas. Estas restricciones se vuelven críticas a medida que tu aplicación escala.

Requisitos de Almacenamiento

Un entero de 32 bits (4 bytes) puede almacenar timestamps a nivel de segundos hasta que ocurra el problema del Año 2038. La mayoría de sistemas modernos usan enteros de 64 bits (8 bytes) para evitar esta limitación.

- Segundos: 8 bytes para un entero de 64 bits con signo (BIGINT)

- Milisegundos: 8 bytes para un entero de 64 bits con signo (BIGINT)

- Microsegundos: 8 bytes para un entero de 64 bits con signo (BIGINT)

Aunque cada nivel de precisión usa el mismo almacenamiento de 8 bytes en bases de datos modernas, el impacto real proviene de las operaciones de indexación y consulta. Los números más grandes requieren más ciclos de CPU para operaciones de comparación, y los árboles B de índices se vuelven ligeramente menos eficientes con valores de clave más grandes.

Rendimiento de Consultas de Base de Datos

Cuando trabajas con timestamps de Unix en bases de datos, el nivel de precisión afecta las consultas de rango y las operaciones de ordenamiento. Una base de datos que compara números de 10 dígitos funciona marginalmente más rápido que comparar números de 16 dígitos, aunque la diferencia solo se vuelve notable con millones de filas.

Más críticamente, mezclar niveles de precisión en tu base de datos crea sobrecarga de conversión. Si tu capa de aplicación envía timestamps en milisegundos pero tu base de datos almacena segundos, cada consulta requiere división por 1,000, evitando el uso eficiente del índice.

Consideraciones de Red y API

Los payloads JSON transmiten timestamps como cadenas o números. Un timestamp de microsegundos de 16 dígitos agrega 6 caracteres extra comparado con un timestamp de segundos de 10 dígitos. A través de millones de llamadas de API, esto agrega costos medibles de ancho de banda y sobrecarga de serialización.

Cuándo Usar Segundos

La precisión a nivel de segundos sigue siendo la mejor opción para la mayoría de funciones de cara al usuario donde la percepción humana define la escala de tiempo relevante.

Casos de Uso Ideales

- Publicaciones y comentarios en redes sociales: Los usuarios no perciben diferencias menores a un segundo

- Tareas programadas y trabajos cron: La mayoría de automatizaciones se ejecutan en límites de minutos u horas

- Tokens de autenticación de usuarios: La expiración de sesiones no requiere precisión sub-segundo

- Fechas de publicación de contenido: Artículos, videos y publicaciones de blog usan precisión a nivel de segundos

- Sistemas de reservas y citas: Las citas típicamente se alinean a intervalos de minutos u horas

Pasos de Implementación Accionables

Para implementar timestamps a nivel de segundos efectivamente:

- Usa columnas

BIGINTen tu base de datos para almacenar enteros de 64 bits con signo - Crea índices en columnas de timestamp para consultas de rango como "publicaciones de las últimas 24 horas"

- En JavaScript, convierte timestamps de milisegundos:

Math.floor(Date.now() / 1000) - En Python, usa:

int(time.time()) - Documenta tu elección de precisión en las especificaciones de API para que los consumidores sepan si deben multiplicar por 1,000

Cuándo Usar Milisegundos

La precisión de milisegundos se vuelve necesaria cuando necesitas rastrear eventos que ocurren múltiples veces por segundo o medir duraciones más cortas que un segundo.

Casos de Uso Ideales

- Monitoreo de tiempo de respuesta de APIs: Rastrear si los endpoints responden en 200ms o 800ms

- Transacciones financieras: Registrar la secuencia exacta de operaciones o pasos de procesamiento de pagos

- Mensajería en tiempo real: Ordenar mensajes de chat enviados dentro del mismo segundo

- Analíticas de streaming de video: Registrar eventos de reproducción e incidentes de buffering

- Coordinación de sistemas distribuidos: Sincronizar eventos a través de múltiples servidores

Pasos de Implementación Accionables

Para implementar timestamps a nivel de milisegundos:

- Usa columnas

BIGINTen tu base de datos con documentación clara de que los valores representan milisegundos - En JavaScript, usa

Date.now()directamente (devuelve milisegundos por defecto) - En Python, usa:

int(time.time() * 1000) - Para timestamps de Discord y plataformas similares, los milisegundos proporcionan la precisión estándar

- Agrega validación a nivel de aplicación para asegurar que los timestamps caigan dentro de rangos razonables (no accidentalmente en segundos o microsegundos)

Restricciones del Mundo Real

La precisión de milisegundos introduce un desafío sutil: no todos los sistemas generan timestamps de milisegundos verdaderamente precisos. La resolución del reloj del sistema operativo varía, y los entornos virtualizados pueden actualizar sus relojes solo cada 10-15 milisegundos. Tus timestamps podrían mostrar falsa precisión si el reloj subyacente no soporta verdadera precisión de milisegundos.

Cuándo Usar Microsegundos

La precisión de microsegundos es excesiva para la mayoría de aplicaciones pero se vuelve esencial en dominios especializados que requieren precisión extrema.

Casos de Uso Ideales

- Sistemas de trading de alta frecuencia: Registrar actualizaciones de libros de órdenes que ocurren miles de veces por segundo

- Perfilado de rendimiento y benchmarking: Medir tiempos de ejecución de funciones en el rango de microsegundos

- Recolección de datos científicos: Registrar lecturas de sensores o mediciones experimentales

- Análisis de paquetes de red: Capturar el timing exacto de eventos de red para seguridad o depuración

- Procesamiento de audio/video: Sincronizar streams multimedia a nivel de cuadro o muestra

Pasos de Implementación Accionables

Para implementar timestamps a nivel de microsegundos:

- Verifica que tu lenguaje de programación y base de datos soporten precisión de microsegundos (no todos lo hacen)

- En Python, usa:

int(time.time() * 1_000_000) - En C/C++, usa

gettimeofday()oclock_gettime()conCLOCK_REALTIME - Considera usar bases de datos especializadas de series temporales como InfluxDB o TimescaleDB diseñadas para timestamps de alta precisión

- Documenta el requisito de precisión claramente, ya que la mayoría de desarrolladores asumirán milisegundos por defecto

Restricciones del Mundo Real

Los timestamps de microsegundos crean desafíos significativos en sistemas distribuidos. La latencia de red típicamente se mide en milisegundos, haciendo la sincronización a nivel de microsegundos entre servidores casi imposible sin hardware especializado como relojes sincronizados por GPS. Si tu aplicación se ejecuta en múltiples centros de datos, la precisión de microsegundos puede proporcionar falsa exactitud.

Caso de Estudio: Sistema de Procesamiento de Pedidos de E-commerce

Caso de Estudio Hipotético:

El siguiente ejemplo demuestra la toma de decisiones del mundo real para la precisión de timestamps. Aunque la empresa es ficticia, las restricciones técnicas y soluciones representan escenarios comunes.

ShopFast, una plataforma de e-commerce de tamaño medio, inicialmente construyó su sistema de procesamiento de pedidos usando timestamps de Unix a nivel de segundos. A medida que escalaron a procesar 500 pedidos por minuto durante las horas pico, encontraron un problema crítico.

El Problema

Múltiples pedidos realizados dentro del mismo segundo no podían ordenarse de manera confiable. Cuando los clientes contactaban a soporte preguntando "¿qué pedido se procesó primero?", el sistema no podía proporcionar una respuesta definitiva. Más críticamente, su sistema de detección de fraude necesitaba marcar cuando la misma tarjeta de crédito se usaba para múltiples compras en un período corto, pero la precisión a nivel de segundos hacía esto poco confiable.

El Análisis

El equipo de ingeniería evaluó sus requisitos a través de diferentes componentes del sistema:

- Timestamps de creación de pedidos: Requerían precisión de milisegundos para secuenciación adecuada

- Campos last_updated del catálogo de productos: La precisión de segundos permanecía suficiente

- Logs de procesamiento de pagos: Requerían precisión de milisegundos para detección de fraude

- Fechas de creación de cuentas de clientes: La precisión de segundos permanecía suficiente

- Logging de peticiones de API: Requería precisión de milisegundos para monitoreo de rendimiento

La Solución

En lugar de convertir toda su base de datos a milisegundos, implementaron un enfoque híbrido:

- Migraron

orders.created_atde segundos a milisegundos multiplicando los valores existentes por 1,000 - Actualizaron su capa de API para aceptar y devolver timestamps de milisegundos para endpoints relacionados con pedidos

- Dejaron timestamps de cara al usuario (creación de cuenta, último login) en segundos para minimizar el alcance de la migración

- Agregaron documentación clara distinguiendo qué campos usaban qué precisión

- Implementaron validación a nivel de aplicación para detectar desajustes accidentales de precisión

Los Resultados

Después de la migración, el sistema podía secuenciar pedidos de manera confiable y detectar patrones de fraude. El aumento de almacenamiento fue insignificante (agregar tres dígitos a números existentes), pero la funcionalidad mejorada justificó el esfuerzo de migración. El rendimiento de las consultas permaneció virtualmente idéntico ya que mantuvieron la indexación adecuada.

La lección clave: no necesitas precisión uniforme en toda tu aplicación. Elige el nivel apropiado para cada caso de uso específico basado en requisitos reales, no en preocupaciones teóricas.

Mejores Prácticas para Elegir la Precisión de Timestamps

Sigue estas pautas al implementar timestamps de Unix en tus aplicaciones:

1. Comienza con Segundos, Actualiza Solo Cuando Sea Necesario

Por defecto usa precisión a nivel de segundos a menos que tengas un requisito específico para granularidad más fina. La optimización prematura desperdicia tiempo de desarrollo y crea complejidad innecesaria. La mayoría de aplicaciones nunca necesitan precisión sub-segundo.

2. Mantén Consistencia Dentro de Dominios

Usa el mismo nivel de precisión para timestamps relacionados. Si tu tabla orders usa milisegundos, tus tablas order_items y order_payments deberían coincidir. Mezclar niveles de precisión fuerza conversión constante y crea bugs.

3. Documenta Tu Elección de Precisión

Agrega comentarios en tu esquema de base de datos, documentación de API y código explicando si los timestamps representan segundos, milisegundos o microsegundos. Un valor de timestamp de 1704067200000 es ambiguo sin contexto.

4. Valida Rangos de Timestamps

Implementa validación para detectar errores de precisión. Un timestamp en segundos debería caer entre aproximadamente 1,000,000,000 (septiembre 2001) y 2,000,000,000 (mayo 2033) para fechas actuales. Un timestamp de milisegundos debería ser aproximadamente 1,000 veces mayor. Detectar estos errores temprano previene corrupción de datos.

5. Considera los Tipos Nativos de Tu Base de Datos

Algunas bases de datos ofrecen tipos de timestamp nativos con precisión incorporada. El tipo TIMESTAMP de PostgreSQL almacena precisión de microsegundos internamente. El tipo DATETIME de MySQL soporta microsegundos desde la versión 5.6.4. Estos tipos nativos a menudo proporcionan mejor optimización de consultas que almacenar enteros sin procesar.

6. Ten en Cuenta el Desfase de Reloj en Sistemas Distribuidos

Si estás comparando timestamps generados por diferentes servidores, incluso la precisión de milisegundos puede ser engañosa sin sincronización adecuada del reloj. Implementa NTP (Network Time Protocol) en todos los servidores y considera usar relojes lógicos (como timestamps de Lamport o relojes vectoriales) para ordenar eventos en sistemas distribuidos.

7. Prueba la Lógica de Conversión Exhaustivamente

Al convertir entre niveles de precisión, prueba casos extremos como timestamps negativos (fechas antes de 1970), timestamps muy grandes (fechas del futuro lejano) y los límites de tus tipos de enteros. Un entero de 32 bits no puede almacenar timestamps de milisegundos más allá de 2038.

8. Planifica para el Problema del Año 2038

Si estás usando timestamps a nivel de segundos, asegúrate de estar usando enteros de 64 bits, no de 32 bits. El problema del Año 2038 solo afecta a enteros con signo de 32 bits. Seguir las mejores prácticas del tutorial de timestamps de Unix ayuda a preparar tu aplicación para el futuro.

Conclusión

Elegir entre segundos vs milisegundos vs microsegundos para timestamps de Unix depende de los requisitos específicos de tu aplicación, no de preferencias técnicas arbitrarias. La precisión a nivel de segundos maneja la mayoría de funciones de cara al usuario eficientemente, la precisión de milisegundos habilita monitoreo de APIs y coordinación en tiempo real, y la precisión de microsegundos sirve a aplicaciones especializadas de alta frecuencia. Comienza con la opción más simple que cumpla tus necesidades, mantén consistencia dentro de datos relacionados y documenta tus elecciones claramente. Al entender los compromisos prácticos entre almacenamiento, rendimiento y precisión, puedes tomar decisiones informadas que escalen con el crecimiento de tu aplicación.

Convierte Entre Formatos de Timestamp Instantáneamente

Convierte Entre Formatos de Timestamp Instantáneamente

Cambia entre segundos, milisegundos y microsegundos con nuestra herramienta gratuita de conversión de timestamps de Unix. No se requiere programación.

Prueba Nuestra Herramienta Gratuita →