Lorsque tu travailles avec des timestamps Unix, choisir entre secondes vs millisecondes vs microsecondes peut impacter significativement les performances de ton application, ses besoins en stockage et sa précision. Bien que les timestamps Unix mesurent traditionnellement le temps en secondes depuis le 1er janvier 1970, les applications modernes exigent souvent une plus grande précision pour enregistrer des événements, mesurer les temps de réponse API ou synchroniser des systèmes distribués. Ce guide détaille les différences pratiques entre chaque niveau de précision et fournit des critères clairs pour t'aider à faire le bon choix selon ton cas d'usage spécifique.

Table des matières

- Comprendre les trois niveaux de précision

- Implications en termes de stockage et de performance

- Quand utiliser les secondes

- Quand utiliser les millisecondes

- Quand utiliser les microsecondes

- Étude de cas : Système de traitement de commandes e-commerce

- Bonnes pratiques pour choisir la précision des timestamps

- Conclusion

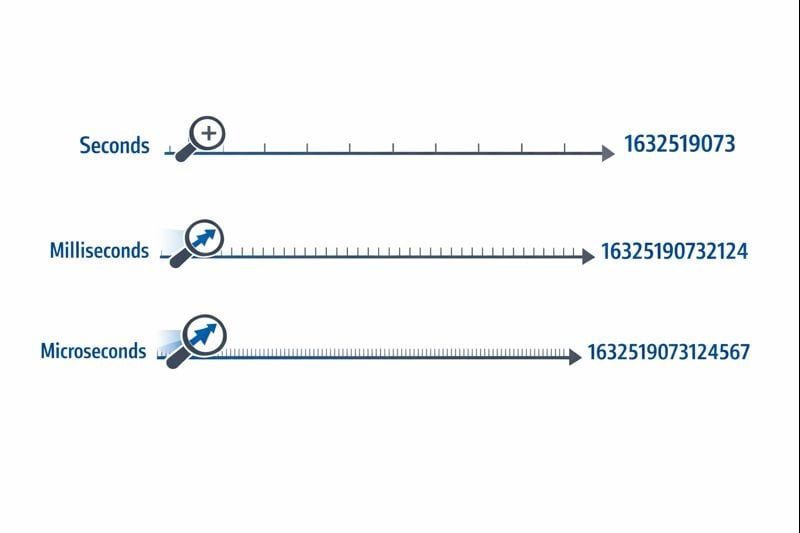

Comprendre les trois niveaux de précision

Les timestamps Unix représentent le temps comme un nombre unique comptant depuis le point de référence de l'epoch time. Le niveau de précision détermine avec quelle finesse tu peux mesurer les intervalles de temps.

Secondes (10 chiffres) : Le format original des timestamps Unix utilise un entier 32 bits ou 64 bits représentant des secondes entières. Une valeur typique ressemble à 1704067200, qui représente exactement un moment dans le temps sans subdivisions.

Millisecondes (13 chiffres) : Ce format multiplie la valeur en secondes par 1 000, ajoutant trois décimales de précision. Le même moment devient 1704067200000. La fonction Date.now() de JavaScript renvoie des timestamps dans ce format par défaut.

Microsecondes (16 chiffres) : Utilisé principalement dans les systèmes nécessitant une précision extrême, ce format multiplie les secondes par 1 000 000. La valeur devient 1704067200000000. Des langages comme time.time_ns() de Python peuvent travailler avec une précision à la nanoseconde (19 chiffres), bien que les microsecondes représentent la limite supérieure pratique pour la plupart des applications.

Le niveau de précision que tu choisis affecte directement la taille de ta base de données, la consommation de mémoire et les performances des requêtes. Ces contraintes deviennent critiques à mesure que ton application évolue.

Besoins en stockage

Un entier 32 bits (4 octets) peut stocker des timestamps au niveau de la seconde jusqu'à ce que le problème de l'an 2038 se produise. La plupart des systèmes modernes utilisent des entiers 64 bits (8 octets) pour éviter cette limitation.

- Secondes : 8 octets pour un entier signé 64 bits (BIGINT)

- Millisecondes : 8 octets pour un entier signé 64 bits (BIGINT)

- Microsecondes : 8 octets pour un entier signé 64 bits (BIGINT)

Bien que chaque niveau de précision utilise les mêmes 8 octets de stockage dans les bases de données modernes, l'impact réel provient des opérations d'indexation et de requêtes. Les nombres plus grands nécessitent plus de cycles CPU pour les opérations de comparaison, et les arbres B des index deviennent légèrement moins efficaces avec des valeurs de clés plus grandes.

Performance des requêtes en base de données

Lorsque tu travailles avec des timestamps Unix dans les bases de données, le niveau de précision affecte les requêtes de plage et les opérations de tri. Une base de données comparant des nombres à 10 chiffres est marginalement plus rapide que pour des nombres à 16 chiffres, bien que la différence ne devienne perceptible qu'à partir de millions de lignes.

Plus critique encore, mélanger les niveaux de précision dans ta base de données crée une surcharge de conversion. Si ta couche applicative envoie des timestamps en millisecondes mais que ta base de données stocke en secondes, chaque requête nécessite une division par 1 000, empêchant l'utilisation efficace des index.

Considérations réseau et API

Les charges utiles JSON transmettent les timestamps sous forme de chaînes ou de nombres. Un timestamp en microsecondes de 16 chiffres ajoute 6 caractères supplémentaires par rapport à un timestamp en secondes de 10 chiffres. Sur des millions d'appels API, cela ajoute des coûts de bande passante et une surcharge de sérialisation mesurables.

Quand utiliser les secondes

La précision au niveau de la seconde reste le meilleur choix pour la plupart des fonctionnalités orientées utilisateur où la perception humaine définit l'échelle de temps pertinente.

Cas d'usage idéaux

- Publications et commentaires sur les réseaux sociaux : Les utilisateurs ne perçoivent pas les différences de moins d'une seconde

- Tâches planifiées et tâches cron : La plupart de l'automatisation s'exécute sur des limites de minutes ou d'heures

- Jetons d'authentification utilisateur : L'expiration de session ne nécessite pas une précision inférieure à la seconde

- Dates de publication de contenu : Articles, vidéos et articles de blog utilisent une précision au niveau de la seconde

- Systèmes de réservation : Les rendez-vous s'alignent généralement sur des créneaux de minutes ou d'heures

Étapes de mise en œuvre concrètes

Pour implémenter efficacement des timestamps au niveau de la seconde :

- Utilise des colonnes

BIGINTdans ta base de données pour stocker des entiers signés 64 bits - Crée des index sur les colonnes de timestamps pour les requêtes de plage comme "publications des dernières 24 heures"

- En JavaScript, convertis les timestamps en millisecondes :

Math.floor(Date.now() / 1000) - En Python, utilise :

int(time.time()) - Documente ton choix de précision dans les spécifications API pour que les consommateurs sachent s'ils doivent multiplier par 1 000

Quand utiliser les millisecondes

La précision à la milliseconde devient nécessaire lorsque tu dois suivre des événements qui se produisent plusieurs fois par seconde ou mesurer des durées inférieures à une seconde.

Cas d'usage idéaux

- Surveillance du temps de réponse API : Suivre si les endpoints répondent en 200 ms ou 800 ms

- Transactions financières : Enregistrer la séquence exacte des transactions ou des étapes de traitement des paiements

- Messagerie en temps réel : Ordonner les messages de chat envoyés dans la même seconde

- Analytique de streaming vidéo : Enregistrer les événements de lecture et les incidents de mise en mémoire tampon

- Coordination de systèmes distribués : Synchroniser les événements sur plusieurs serveurs

Étapes de mise en œuvre concrètes

Pour implémenter des timestamps au niveau de la milliseconde :

- Utilise des colonnes

BIGINTdans ta base de données avec une documentation claire indiquant que les valeurs représentent des millisecondes - En JavaScript, utilise

Date.now()directement (il renvoie des millisecondes par défaut) - En Python, utilise :

int(time.time() * 1000) - Pour les timestamps Discord et les plateformes similaires, les millisecondes fournissent la précision standard

- Ajoute une validation au niveau de l'application pour t'assurer que les timestamps tombent dans des plages raisonnables (pas accidentellement en secondes ou microsecondes)

Contraintes du monde réel

La précision à la milliseconde introduit un défi subtil : tous les systèmes ne génèrent pas des timestamps vraiment précis à la milliseconde. La résolution de l'horloge du système d'exploitation varie, et les environnements virtualisés peuvent ne mettre à jour leurs horloges que toutes les 10-15 millisecondes. Tes timestamps peuvent afficher une fausse précision si l'horloge sous-jacente ne supporte pas une vraie précision à la milliseconde.

Quand utiliser les microsecondes

La précision à la microseconde est excessive pour la plupart des applications mais devient essentielle dans des domaines spécialisés nécessitant une précision extrême.

Cas d'usage idéaux

- Systèmes de trading haute fréquence : Enregistrer les mises à jour du carnet d'ordres qui se produisent des milliers de fois par seconde

- Profilage et benchmarking de performance : Mesurer les temps d'exécution de fonctions dans la plage de la microseconde

- Collecte de données scientifiques : Enregistrer les lectures de capteurs ou les mesures expérimentales

- Analyse de paquets réseau : Capturer le timing exact des événements réseau pour la sécurité ou le débogage

- Traitement audio/vidéo : Synchroniser les flux multimédias au niveau de la trame ou de l'échantillon

Étapes de mise en œuvre concrètes

Pour implémenter des timestamps au niveau de la microseconde :

- Vérifie que ton langage de programmation et ta base de données supportent la précision à la microseconde (ce n'est pas le cas de tous)

- En Python, utilise :

int(time.time() * 1_000_000) - En C/C++, utilise

gettimeofday()ouclock_gettime()avecCLOCK_REALTIME - Envisage d'utiliser des bases de données de séries temporelles spécialisées comme InfluxDB ou TimescaleDB conçues pour les timestamps haute précision

- Documente clairement l'exigence de précision, car la plupart des développeurs supposeront des millisecondes par défaut

Contraintes du monde réel

Les timestamps en microsecondes créent des défis importants dans les systèmes distribués. La latence réseau se mesure généralement en millisecondes, rendant la synchronisation au niveau de la microseconde sur plusieurs serveurs presque impossible sans matériel spécialisé comme des horloges synchronisées par GPS. Si ton application fonctionne sur plusieurs centres de données, la précision à la microseconde peut fournir une fausse exactitude.

Étude de cas : Système de traitement de commandes e-commerce

Étude de cas hypothétique :

L'exemple suivant démontre la prise de décision réelle pour la précision des timestamps. Bien que l'entreprise soit fictive, les contraintes techniques et les solutions représentent des scénarios courants.

ShopFast, une plateforme e-commerce de taille moyenne, a initialement construit son système de traitement de commandes en utilisant des timestamps Unix au niveau de la seconde. À mesure qu'ils ont évolué pour traiter 500 commandes par minute pendant les heures de pointe, ils ont rencontré un problème critique.

Le problème

Plusieurs commandes passées dans la même seconde ne pouvaient pas être triées de manière fiable. Lorsque les clients contactaient le support en demandant "quelle commande est passée en premier ?", le système ne pouvait pas fournir de réponse définitive. Plus critique encore, leur système de détection de fraude devait signaler quand la même carte de crédit était utilisée pour plusieurs achats dans une courte fenêtre, mais la précision au niveau de la seconde rendait cela peu fiable.

L'analyse

L'équipe d'ingénierie a évalué leurs exigences sur différents composants du système :

- Timestamps de création de commandes : Nécessitait une précision à la milliseconde pour un séquençage approprié

- Champs last_updated du catalogue de produits : La précision à la seconde restait suffisante

- Journaux de traitement des paiements : Nécessitait une précision à la milliseconde pour la détection de fraude

- Dates de création de comptes clients : La précision à la seconde restait suffisante

- Journalisation des requêtes API : Nécessitait une précision à la milliseconde pour la surveillance des performances

La solution

Plutôt que de convertir toute leur base de données en millisecondes, ils ont mis en œuvre une approche hybride :

- Migration de

orders.created_atdes secondes aux millisecondes en multipliant les valeurs existantes par 1 000 - Mise à jour de leur couche API pour accepter et renvoyer des timestamps en millisecondes pour les endpoints liés aux commandes

- Conservation des timestamps orientés utilisateur (création de compte, dernière connexion) en secondes pour minimiser la portée de la migration

- Ajout d'une documentation claire distinguant quels champs utilisent quelle précision

- Implémentation d'une validation au niveau de l'application pour détecter les décalages de précision accidentels

Les résultats

Après la migration, le système pouvait séquencer les commandes de manière fiable et détecter les modèles de fraude. L'augmentation du stockage était négligeable (ajout de trois chiffres aux nombres existants), mais la fonctionnalité améliorée justifiait l'effort de migration. Les performances des requêtes sont restées pratiquement identiques car ils ont maintenu une indexation appropriée.

La leçon clé : tu n'as pas besoin d'une précision uniforme dans toute ton application. Choisis le niveau approprié pour chaque cas d'usage spécifique en fonction des exigences réelles, pas des préoccupations théoriques.

Bonnes pratiques pour choisir la précision des timestamps

Suis ces directives lors de l'implémentation de timestamps Unix dans tes applications :

1. Commence avec les secondes, améliore seulement si nécessaire

Par défaut, utilise la précision au niveau de la seconde sauf si tu as une exigence spécifique pour une granularité plus fine. L'optimisation prématurée gaspille du temps de développement et crée une complexité inutile. La plupart des applications n'ont jamais besoin d'une précision inférieure à la seconde.

2. Maintiens la cohérence au sein des domaines

Utilise le même niveau de précision pour les timestamps liés. Si ta table orders utilise des millisecondes, tes tables order_items et order_payments devraient correspondre. Mélanger les niveaux de précision force une conversion constante et crée des bugs.

3. Documente ton choix de précision

Ajoute des commentaires dans ton schéma de base de données, ta documentation API et ton code expliquant si les timestamps représentent des secondes, millisecondes ou microsecondes. Une valeur de timestamp de 1704067200000 est ambiguë sans contexte.

4. Valide les plages de timestamps

Implémente une validation pour détecter les erreurs de précision. Un timestamp en secondes devrait se situer entre environ 1 000 000 000 (septembre 2001) et 2 000 000 000 (mai 2033) pour les dates actuelles. Un timestamp en millisecondes devrait être environ 1 000 fois plus grand. Détecter ces erreurs tôt prévient la corruption des données.

5. Considère les types natifs de ta base de données

Certaines bases de données offrent des types timestamp natifs avec une précision intégrée. Le type TIMESTAMP de PostgreSQL stocke la précision à la microseconde en interne. Le type DATETIME de MySQL supporte les microsecondes depuis la version 5.6.4. Ces types natifs offrent souvent une meilleure optimisation des requêtes que le stockage d'entiers bruts.

6. Tiens compte de la dérive d'horloge dans les systèmes distribués

Si tu compares des timestamps générés par différents serveurs, même la précision à la milliseconde peut être trompeuse sans synchronisation d'horloge appropriée. Implémente NTP (Network Time Protocol) sur tous les serveurs et envisage d'utiliser des horloges logiques (comme les timestamps de Lamport ou les horloges vectorielles) pour ordonner les événements dans les systèmes distribués.

7. Teste minutieusement la logique de conversion

Lors de la conversion entre niveaux de précision, teste les cas limites comme les timestamps négatifs (dates avant 1970), les très grands timestamps (dates du futur lointain) et les limites de tes types d'entiers. Un entier 32 bits ne peut pas stocker de timestamps en millisecondes au-delà de 2038.

8. Planifie pour le problème de l'an 2038

Si tu utilises des timestamps au niveau de la seconde, assure-toi d'utiliser des entiers 64 bits, pas 32 bits. Le problème de l'an 2038 n'affecte que les entiers signés 32 bits. Suivre les bonnes pratiques du tutoriel sur les timestamps Unix aide à pérenniser ton application.

Conclusion

Choisir entre secondes vs millisecondes vs microsecondes pour les timestamps Unix dépend de tes exigences applicatives spécifiques, pas de préférences techniques arbitraires. La précision au niveau de la seconde gère efficacement la plupart des fonctionnalités orientées utilisateur, la précision à la milliseconde permet la surveillance d'API et la coordination en temps réel, et la précision à la microseconde sert les applications haute fréquence spécialisées. Commence avec l'option la plus simple qui répond à tes besoins, maintiens la cohérence au sein des données liées et documente clairement tes choix. En comprenant les compromis pratiques entre stockage, performance et précision, tu peux prendre des décisions éclairées qui évoluent avec la croissance de ton application.

Convertis instantanément entre les formats de timestamps

Convertis instantanément entre les formats de timestamps

Bascule entre secondes, millisecondes et microsecondes avec notre convertisseur de timestamps Unix gratuit. Aucun codage requis.

Essaie notre outil gratuit →