Quando lavori con i timestamp Unix, scegliere tra secondi vs millisecondi vs microsecondi può avere un impatto significativo sulle prestazioni della tua applicazione, sui requisiti di archiviazione e sulla precisione. Mentre i timestamp Unix tradizionalmente misurano il tempo in secondi dal 1 gennaio 1970, le applicazioni moderne richiedono spesso una precisione maggiore per registrare eventi, misurare i tempi di risposta delle API o sincronizzare sistemi distribuiti. Questa guida analizza le differenze pratiche tra ogni livello di precisione e fornisce criteri chiari per aiutarti a fare la scelta giusta per il tuo caso d'uso specifico.

Indice dei Contenuti

Comprendere i Tre Livelli di Precisione

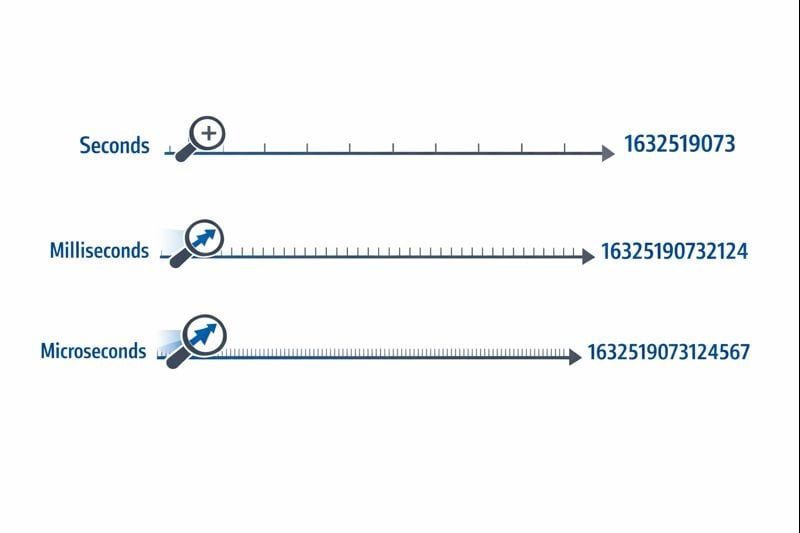

I timestamp Unix rappresentano il tempo come un singolo numero che conta dal punto di riferimento dell'epoch time. Il livello di precisione determina quanto finemente puoi misurare gli intervalli di tempo.

Secondi (10 cifre): Il formato originale del timestamp Unix usa un intero a 32 bit o 64 bit che rappresenta secondi interi. Un valore tipico appare come 1704067200, che rappresenta esattamente un momento nel tempo senza suddivisioni.

Millisecondi (13 cifre): Questo formato moltiplica il valore dei secondi per 1.000, aggiungendo tre decimali di precisione. Lo stesso momento diventa 1704067200000. La funzione Date.now() di JavaScript restituisce timestamp in questo formato per impostazione predefinita.

Microsecondi (16 cifre): Usato principalmente in sistemi che richiedono precisione estrema, questo formato moltiplica i secondi per 1.000.000. Il valore diventa 1704067200000000. Linguaggi come time.time_ns() di Python possono lavorare anche con precisione al nanosecondo (19 cifre), anche se i microsecondi rappresentano il limite superiore pratico per la maggior parte delle applicazioni.

Implicazioni su Archiviazione e Prestazioni

Il livello di precisione che scegli influisce direttamente sulla dimensione del database, sul consumo di memoria e sulle prestazioni delle query. Questi vincoli diventano critici quando la tua applicazione si scala.

Requisiti di Archiviazione

Un intero a 32 bit (4 byte) può memorizzare timestamp al secondo fino a quando si verifica il problema dell'anno 2038. La maggior parte dei sistemi moderni usa interi a 64 bit (8 byte) per evitare questa limitazione.

- Secondi: 8 byte per un intero a 64 bit con segno (BIGINT)

- Millisecondi: 8 byte per un intero a 64 bit con segno (BIGINT)

- Microsecondi: 8 byte per un intero a 64 bit con segno (BIGINT)

Mentre ogni livello di precisione usa gli stessi 8 byte di archiviazione nei database moderni, l'impatto reale deriva dalle operazioni di indicizzazione e query. I numeri più grandi richiedono più cicli CPU per le operazioni di confronto, e i B-tree degli indici diventano leggermente meno efficienti con valori di chiave più grandi.

Prestazioni delle Query del Database

Quando lavori con timestamp Unix nei database, il livello di precisione influisce sulle query di intervallo e sulle operazioni di ordinamento. Un database che confronta numeri a 10 cifre funziona marginalmente più veloce rispetto al confronto di numeri a 16 cifre, anche se la differenza diventa evidente solo con milioni di righe.

Più criticamente, mescolare livelli di precisione nel tuo database crea overhead di conversione. Se il tuo livello applicativo invia timestamp in millisecondi ma il tuo database memorizza secondi, ogni query richiede una divisione per 1.000, impedendo l'uso efficiente degli indici.

Considerazioni su Rete e API

I payload JSON trasmettono timestamp come stringhe o numeri. Un timestamp in microsecondi a 16 cifre aggiunge 6 caratteri extra rispetto a un timestamp in secondi a 10 cifre. Su milioni di chiamate API, questo aggiunge costi di larghezza di banda misurabili e overhead di serializzazione.

Quando Usare i Secondi

La precisione al secondo rimane la scelta migliore per la maggior parte delle funzionalità rivolte agli utenti dove la percezione umana definisce la scala temporale rilevante.

Casi d'Uso Ideali

- Post e commenti sui social media: Gli utenti non percepiscono differenze inferiori a un secondo

- Attività pianificate e cron job: La maggior parte dell'automazione funziona su limiti di minuti o ore

- Token di autenticazione utente: La scadenza della sessione non richiede precisione al di sotto del secondo

- Date di pubblicazione dei contenuti: Articoli, video e post di blog usano precisione al secondo

- Sistemi di prenotazione e prenotazioni: Gli appuntamenti si allineano tipicamente a slot di minuti o ore

Passaggi di Implementazione Pratici

Per implementare efficacemente timestamp al secondo:

- Usa colonne

BIGINTnel tuo database per memorizzare interi a 64 bit con segno - Crea indici sulle colonne timestamp per query di intervallo come "post delle ultime 24 ore"

- In JavaScript, converti timestamp in millisecondi:

Math.floor(Date.now() / 1000) - In Python, usa:

int(time.time()) - Documenta la tua scelta di precisione nelle specifiche API in modo che i consumatori sappiano se moltiplicare per 1.000

Quando Usare i Millisecondi

La precisione al millisecondo diventa necessaria quando devi tracciare eventi che si verificano più volte al secondo o misurare durate inferiori a un secondo.

Casi d'Uso Ideali

- Monitoraggio dei tempi di risposta delle API: Tracciare se gli endpoint rispondono entro 200ms o 800ms

- Transazioni finanziarie: Registrare la sequenza esatta di operazioni o passaggi di elaborazione dei pagamenti

- Messaggistica in tempo reale: Ordinare messaggi di chat inviati nello stesso secondo

- Analisi dello streaming video: Registrare eventi di riproduzione e incidenti di buffering

- Coordinamento di sistemi distribuiti: Sincronizzare eventi su più server

Passaggi di Implementazione Pratici

Per implementare timestamp al millisecondo:

- Usa colonne

BIGINTnel tuo database con documentazione chiara che i valori rappresentano millisecondi - In JavaScript, usa

Date.now()direttamente (restituisce millisecondi per impostazione predefinita) - In Python, usa:

int(time.time() * 1000) - Per timestamp Discord e piattaforme simili, i millisecondi forniscono la precisione standard

- Aggiungi validazione a livello applicativo per assicurarti che i timestamp rientrino in intervalli ragionevoli (non accidentalmente in secondi o microsecondi)

Vincoli del Mondo Reale

La precisione al millisecondo introduce una sfida sottile: non tutti i sistemi generano timestamp al millisecondo veramente accurati. La risoluzione dell'orologio del sistema operativo varia, e gli ambienti virtualizzati potrebbero aggiornare i loro orologi solo ogni 10-15 millisecondi. I tuoi timestamp potrebbero mostrare falsa precisione se l'orologio sottostante non supporta vera accuratezza al millisecondo.

Quando Usare i Microsecondi

La precisione al microsecondo è eccessiva per la maggior parte delle applicazioni ma diventa essenziale in domini specializzati che richiedono accuratezza estrema.

Casi d'Uso Ideali

- Sistemi di trading ad alta frequenza: Registrare aggiornamenti del book degli ordini che si verificano migliaia di volte al secondo

- Profilazione delle prestazioni e benchmarking: Misurare tempi di esecuzione delle funzioni nell'intervallo dei microsecondi

- Raccolta dati scientifici: Registrare letture di sensori o misurazioni sperimentali

- Analisi dei pacchetti di rete: Catturare il timing esatto degli eventi di rete per sicurezza o debugging

- Elaborazione audio/video: Sincronizzare stream multimediali a livello di frame o campione

Passaggi di Implementazione Pratici

Per implementare timestamp al microsecondo:

- Verifica che il tuo linguaggio di programmazione e database supportino la precisione al microsecondo (non tutti lo fanno)

- In Python, usa:

int(time.time() * 1_000_000) - In C/C++, usa

gettimeofday()oclock_gettime()conCLOCK_REALTIME - Considera l'uso di database time-series specializzati come InfluxDB o TimescaleDB progettati per timestamp ad alta precisione

- Documenta chiaramente il requisito di precisione, poiché la maggior parte degli sviluppatori assumerà millisecondi per impostazione predefinita

Vincoli del Mondo Reale

I timestamp al microsecondo creano sfide significative nei sistemi distribuiti. La latenza di rete si misura tipicamente in millisecondi, rendendo la sincronizzazione a livello di microsecondo tra server quasi impossibile senza hardware specializzato come orologi sincronizzati GPS. Se la tua applicazione funziona su più data center, la precisione al microsecondo potrebbe fornire falsa accuratezza.

Caso Studio: Sistema di Elaborazione Ordini E-commerce

Caso Studio Ipotetico:

Il seguente esempio dimostra il processo decisionale reale per la precisione dei timestamp. Anche se l'azienda è fittizia, i vincoli tecnici e le soluzioni rappresentano scenari comuni.

ShopFast, una piattaforma e-commerce di medie dimensioni, inizialmente ha costruito il loro sistema di elaborazione ordini usando timestamp Unix al secondo. Quando sono arrivati a elaborare 500 ordini al minuto durante le ore di punta, hanno incontrato un problema critico.

Il Problema

Più ordini effettuati nello stesso secondo non potevano essere ordinati in modo affidabile. Quando i clienti contattavano il supporto chiedendo "quale ordine è passato per primo?", il sistema non poteva fornire una risposta definitiva. Più criticamente, il loro sistema di rilevamento frodi doveva segnalare quando la stessa carta di credito veniva usata per più acquisti in una breve finestra, ma la precisione al secondo rendeva questo inaffidabile.

L'Analisi

Il team di ingegneria ha valutato i loro requisiti attraverso diversi componenti del sistema:

- Timestamp di creazione ordini: Richiedeva precisione al millisecondo per un sequenziamento corretto

- Campi last_updated del catalogo prodotti: La precisione al secondo rimaneva sufficiente

- Log di elaborazione pagamenti: Richiedeva precisione al millisecondo per il rilevamento frodi

- Date di creazione account cliente: La precisione al secondo rimaneva sufficiente

- Logging delle richieste API: Richiedeva precisione al millisecondo per il monitoraggio delle prestazioni

La Soluzione

Invece di convertire l'intero database in millisecondi, hanno implementato un approccio ibrido:

- Hanno migrato

orders.created_atda secondi a millisecondi moltiplicando i valori esistenti per 1.000 - Hanno aggiornato il loro livello API per accettare e restituire timestamp in millisecondi per gli endpoint relativi agli ordini

- Hanno lasciato i timestamp rivolti agli utenti (creazione account, ultimo accesso) in secondi per minimizzare l'ambito della migrazione

- Hanno aggiunto documentazione chiara che distingue quali campi usano quale precisione

- Hanno implementato validazione a livello applicativo per catturare discrepanze accidentali di precisione

I Risultati

Dopo la migrazione, il sistema poteva sequenziare in modo affidabile gli ordini e rilevare pattern di frode. L'aumento di archiviazione era trascurabile (aggiungendo tre cifre ai numeri esistenti), ma la funzionalità migliorata giustificava lo sforzo di migrazione. Le prestazioni delle query rimanevano praticamente identiche poiché mantenevano un'indicizzazione corretta.

La lezione chiave: non hai bisogno di precisione uniforme in tutta la tua applicazione. Scegli il livello appropriato per ogni caso d'uso specifico basato su requisiti reali, non su preoccupazioni teoriche.

Best Practice per Scegliere la Precisione dei Timestamp

Segui queste linee guida quando implementi timestamp Unix nelle tue applicazioni:

1. Inizia con i Secondi, Aggiorna Solo Quando Necessario

Predefinisci la precisione al secondo a meno che tu non abbia un requisito specifico per una granularità più fine. L'ottimizzazione prematura spreca tempo di sviluppo e crea complessità non necessaria. La maggior parte delle applicazioni non ha mai bisogno di precisione al di sotto del secondo.

2. Mantieni Coerenza all'Interno dei Domini

Usa lo stesso livello di precisione per timestamp correlati. Se la tua tabella orders usa millisecondi, le tue tabelle order_items e order_payments dovrebbero corrispondere. Mescolare livelli di precisione forza conversioni costanti e crea bug.

3. Documenta la Tua Scelta di Precisione

Aggiungi commenti nello schema del tuo database, documentazione API e codice spiegando se i timestamp rappresentano secondi, millisecondi o microsecondi. Un valore timestamp di 1704067200000 è ambiguo senza contesto.

4. Valida gli Intervalli dei Timestamp

Implementa validazione per catturare errori di precisione. Un timestamp in secondi dovrebbe rientrare tra circa 1.000.000.000 (settembre 2001) e 2.000.000.000 (maggio 2033) per le date attuali. Un timestamp in millisecondi dovrebbe essere circa 1.000 volte più grande. Catturare questi errori presto previene la corruzione dei dati.

5. Considera i Tipi Nativi del Tuo Database

Alcuni database offrono tipi timestamp nativi con precisione integrata. Il tipo TIMESTAMP di PostgreSQL memorizza internamente precisione al microsecondo. Il tipo DATETIME di MySQL supporta microsecondi dalla versione 5.6.4. Questi tipi nativi spesso forniscono una migliore ottimizzazione delle query rispetto alla memorizzazione di interi grezzi.

6. Considera il Clock Drift nei Sistemi Distribuiti

Se stai confrontando timestamp generati da server diversi, anche la precisione al millisecondo può essere fuorviante senza una corretta sincronizzazione dell'orologio. Implementa NTP (Network Time Protocol) su tutti i server e considera l'uso di orologi logici (come timestamp Lamport o orologi vettoriali) per ordinare eventi nei sistemi distribuiti.

7. Testa Accuratamente la Logica di Conversione

Quando converti tra livelli di precisione, testa casi limite come timestamp negativi (date prima del 1970), timestamp molto grandi (date molto future) e i limiti dei tuoi tipi interi. Un intero a 32 bit non può memorizzare timestamp in millisecondi oltre il 2038.

8. Pianifica per il Problema dell'Anno 2038

Se stai usando timestamp al secondo, assicurati di usare interi a 64 bit, non a 32 bit. Il problema dell'anno 2038 colpisce solo interi con segno a 32 bit. Seguire le best practice del tutorial sui timestamp Unix aiuta a rendere la tua applicazione a prova di futuro.

Conclusione

Scegliere tra secondi vs millisecondi vs microsecondi per i timestamp Unix dipende dai tuoi requisiti applicativi specifici, non da preferenze tecniche arbitrarie. La precisione al secondo gestisce efficacemente la maggior parte delle funzionalità rivolte agli utenti, la precisione al millisecondo abilita il monitoraggio API e la coordinazione in tempo reale, e la precisione al microsecondo serve applicazioni specializzate ad alta frequenza. Inizia con l'opzione più semplice che soddisfa le tue esigenze, mantieni coerenza all'interno dei dati correlati e documenta chiaramente le tue scelte. Comprendendo i compromessi pratici tra archiviazione, prestazioni e precisione, puoi prendere decisioni informate che si scalano con la crescita della tua applicazione.

Converti Istantaneamente tra Formati di Timestamp

Passa tra secondi, millisecondi e microsecondi con il nostro convertitore di timestamp Unix gratuito. Non serve programmare.

Prova il Nostro Strumento Gratuito →