Unix timestampを扱う際、秒 vs ミリ秒 vs マイクロ秒の選択は、アプリケーションのパフォーマンス、ストレージ要件、精度に大きく影響します。Unix timestampは伝統的に1970年1月1日からの秒数を測定しますが、現代のアプリケーションでは、イベントのログ記録、APIレスポンスタイムの測定、分散システムの同期などのために、より高い精度が求められることがよくあります。このガイドでは、各精度レベルの実用的な違いを詳しく説明し、具体的なユースケースに応じた適切な選択を行うための明確な基準を提供します。

目次

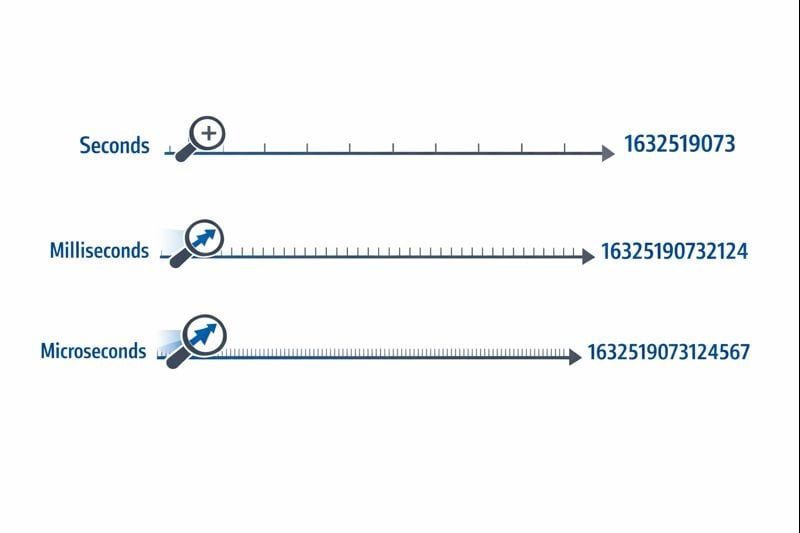

3つの精度レベルの理解

Unix timestampは、エポック時間基準点からカウントする単一の数値として時間を表します。精度レベルによって、時間間隔をどれだけ細かく測定できるかが決まります。

秒(10桁): 元のUnix timestamp形式は、整数秒を表す32ビットまたは64ビット整数を使用します。典型的な値は1704067200のようになり、細分化されない1つの瞬間を正確に表します。

ミリ秒(13桁): この形式は秒の値を1,000倍し、3桁の小数点以下の精度を追加します。同じ瞬間は1704067200000になります。JavaScriptのDate.now()関数は、デフォルトでこの形式のtimestampを返します。

マイクロ秒(16桁): 主に極めて高い精度を必要とするシステムで使用されるこの形式は、秒を1,000,000倍します。値は1704067200000000になります。Pythonのtime.time_ns()のような言語は、ナノ秒精度(19桁)でも動作できますが、マイクロ秒がほとんどのアプリケーションにとって実用的な上限です。

選択する精度レベルは、データベースサイズ、メモリ消費、クエリパフォーマンスに直接影響します。これらの制約は、アプリケーションがスケールするにつれて重要になります。

ストレージ要件

32ビット整数(4バイト)は、2038年問題が発生するまで秒レベルのtimestampを保存できます。最近のシステムのほとんどは、この制限を回避するために64ビット整数(8バイト)を使用しています。

- 秒: 符号付き64ビット整数(BIGINT)で8バイト

- ミリ秒: 符号付き64ビット整数(BIGINT)で8バイト

- マイクロ秒: 符号付き64ビット整数(BIGINT)で8バイト

各精度レベルは最近のデータベースで同じ8バイトのストレージを使用しますが、実際の影響はインデックス作成とクエリ操作から生じます。大きな数値は比較操作により多くのCPUサイクルを必要とし、インデックスのB-treeは大きなキー値でわずかに効率が低下します。

データベースクエリパフォーマンス

データベースでUnix timestampを扱う際、精度レベルは範囲クエリとソート操作に影響します。データベースが10桁の数値を比較する方が16桁の数値を比較するよりもわずかに高速ですが、違いは数百万行に達して初めて顕著になります。

さらに重要なのは、データベース内で精度レベルを混在させると変換のオーバーヘッドが発生することです。アプリケーション層がミリ秒のtimestampを送信するが、データベースが秒を保存する場合、すべてのクエリで1,000による除算が必要になり、効率的なインデックス使用が妨げられます。

ネットワークとAPIの考慮事項

JSONペイロードはtimestampを文字列または数値として送信します。16桁のマイクロ秒timestampは、10桁の秒timestampと比較して6文字余分に追加されます。数百万のAPI呼び出しにわたって、これは測定可能な帯域幅コストとシリアライゼーションのオーバーヘッドを追加します。

秒を使用するタイミング

秒レベルの精度は、人間の知覚が関連する時間スケールを定義するほとんどのユーザー向け機能にとって最適な選択です。

理想的なユースケース

- ソーシャルメディアの投稿とコメント: ユーザーは1秒未満の違いを知覚しません

- スケジュールされたタスクとcronジョブ: ほとんどの自動化は分または時間の境界で実行されます

- ユーザー認証トークン: セッションの有効期限は秒未満の精度を必要としません

- コンテンツ公開日: 記事、動画、ブログ投稿は秒レベルの精度を使用します

- 予約および予約システム: 予約は通常、分または時間のスロットに整列します

実用的な実装手順

秒レベルのtimestampを効果的に実装するには:

- データベースで

BIGINTカラムを使用して符号付き64ビット整数を保存します - 「過去24時間の投稿」のような範囲クエリのためにtimestampカラムにインデックスを作成します

- JavaScriptでは、ミリ秒timestampを変換します:

Math.floor(Date.now() / 1000) - Pythonでは、次を使用します:

int(time.time()) - 消費者が1,000で乗算する必要があるかどうかを知ることができるように、API仕様で精度の選択を文書化します

ミリ秒を使用するタイミング

ミリ秒の精度は、1秒に複数回発生するイベントを追跡したり、1秒未満の期間を測定したりする必要がある場合に必要になります。

理想的なユースケース

- APIレスポンスタイムのモニタリング: エンドポイントが200msまたは800ms以内に応答するかどうかを追跡します

- 金融取引: 取引または支払い処理ステップの正確な順序を記録します

- リアルタイムメッセージング: 同じ秒内に送信されたチャットメッセージを順序付けします

- 動画ストリーミング分析: 再生イベントとバッファリングインシデントを記録します

- 分散システムの調整: 複数のサーバー間でイベントを同期します

実用的な実装手順

ミリ秒レベルのtimestampを実装するには:

- データベースで

BIGINTカラムを使用し、値がミリ秒を表すことを明確に文書化します - JavaScriptでは、

Date.now()を直接使用します(デフォルトでミリ秒を返します) - Pythonでは、次を使用します:

int(time.time() * 1000) - Discordのtimestampや類似のプラットフォームでは、ミリ秒が標準の精度を提供します

- timestampが妥当な範囲内にあることを確認するために、アプリケーションレベルの検証を追加します(誤って秒またはマイクロ秒になっていないか)

実際の制約

ミリ秒の精度は微妙な課題をもたらします: すべてのシステムが真に正確なミリ秒timestampを生成するわけではありません。オペレーティングシステムのクロック解像度は異なり、仮想化環境では10〜15ミリ秒ごとにクロックを更新するだけかもしれません。基盤となるクロックが真のミリ秒精度をサポートしていない場合、timestampは偽の精度を示す可能性があります。

マイクロ秒を使用するタイミング

マイクロ秒の精度はほとんどのアプリケーションにとって過剰ですが、極度の精度を必要とする特殊な領域では不可欠になります。

理想的なユースケース

- 高頻度取引システム: 1秒間に数千回発生するオーダーブックの更新を記録します

- パフォーマンスプロファイリングとベンチマーク: マイクロ秒範囲での関数実行時間を測定します

- 科学データ収集: センサーの読み取りまたは実験測定をログに記録します

- ネットワークパケット分析: セキュリティまたはデバッグのためにネットワークイベントの正確なタイミングをキャプチャします

- オーディオ/ビデオ処理: フレームまたはサンプルレベルでマルチメディアストリームを同期します

実用的な実装手順

マイクロ秒レベルのtimestampを実装するには:

- プログラミング言語とデータベースがマイクロ秒の精度をサポートしていることを確認します(すべてがサポートしているわけではありません)

- Pythonでは、次を使用します:

int(time.time() * 1_000_000) - C/C++では、

CLOCK_REALTIMEを使用してgettimeofday()またはclock_gettime()を使用します - 高精度timestampのために設計されたInfluxDBやTimescaleDBのような特殊な時系列データベースの使用を検討してください

- ほとんどの開発者がデフォルトでミリ秒を想定するため、精度要件を明確に文書化します

実際の制約

マイクロ秒timestampは分散システムで重大な課題を生み出します。ネットワークレイテンシは通常ミリ秒単位で測定されるため、GPS同期クロックのような特殊なハードウェアなしでは、サーバー間でマイクロ秒レベルの同期はほぼ不可能です。アプリケーションが複数のデータセンターにわたって実行される場合、マイクロ秒の精度は偽の精度を提供する可能性があります。

ケーススタディ: ECサイトの注文処理システム

仮想のケーススタディ:

以下の例は、timestamp精度に関する実際の意思決定を示しています。会社は架空のものですが、技術的な制約と解決策は一般的なシナリオを表しています。

中規模のECプラットフォームであるShopFastは、当初、秒レベルのUnix timestampを使用して注文処理システムを構築しました。ピーク時に1分あたり500件の注文を処理するようにスケールしたとき、彼らは重大な問題に遭遇しました。

問題

同じ秒内に複数の注文が行われた場合、確実にソートできませんでした。顧客がサポートに「どちらの注文が最初に通過したか」と尋ねたとき、システムは明確な答えを提供できませんでした。さらに重要なことに、彼らの不正検出システムは、同じクレジットカードが短時間内に複数の購入に使用されたことをフラグ付けする必要がありましたが、秒レベルの精度ではこれが信頼できませんでした。

分析

エンジニアリングチームは、異なるシステムコンポーネント全体で要件を評価しました:

- 注文作成timestamp: 適切な順序付けのためにミリ秒の精度が必要でした

- 商品カタログのlast_updatedフィールド: 秒の精度で十分でした

- 支払い処理ログ: 不正検出のためにミリ秒の精度が必要でした

- 顧客アカウント作成日: 秒の精度で十分でした

- APIリクエストログ: パフォーマンスモニタリングのためにミリ秒の精度が必要でした

解決策

データベース全体をミリ秒に変換するのではなく、ハイブリッドアプローチを実装しました:

- 既存の値を1,000倍することで、

orders.created_atを秒からミリ秒に移行しました - 注文関連のエンドポイントに対してミリ秒timestampを受け入れて返すようにAPI層を更新しました

- 移行範囲を最小限に抑えるために、ユーザー向けtimestamp(アカウント作成、最終ログイン)を秒のままにしました

- どのフィールドがどの精度を使用するかを区別する明確なドキュメントを追加しました

- 誤った精度の不一致をキャッチするためにアプリケーションレベルの検証を実装しました

結果

移行後、システムは注文を確実に順序付けし、不正パターンを検出できるようになりました。ストレージの増加は無視できるものでした(既存の数値に3桁追加するだけ)が、改善された機能は移行の労力を正当化しました。適切なインデックス作成を維持したため、クエリパフォーマンスは実質的に同じままでした。

重要な教訓: アプリケーション全体で均一な精度は必要ありません。理論的な懸念ではなく、実際の要件に基づいて、各特定のユースケースに適切なレベルを選択してください。

timestamp精度を選択するためのベストプラクティス

アプリケーションでUnix timestampを実装する際は、次のガイドラインに従ってください:

1. 秒から始めて、必要な場合のみアップグレードする

より細かい粒度の特定の要件がない限り、秒レベルの精度をデフォルトにします。時期尚早な最適化は開発時間を無駄にし、不必要な複雑さを生み出します。ほとんどのアプリケーションは秒未満の精度を必要としません。

2. ドメイン内で一貫性を保つ

関連するtimestampには同じ精度レベルを使用します。ordersテーブルがミリ秒を使用する場合、order_itemsとorder_paymentsテーブルも一致させる必要があります。精度レベルを混在させると、常に変換が強制され、バグが発生します。

3. 精度の選択を文書化する

データベーススキーマ、APIドキュメント、コードにコメントを追加して、timestampが秒、ミリ秒、マイクロ秒のいずれを表すかを説明します。1704067200000というtimestamp値は、コンテキストなしでは曖昧です。

4. timestamp範囲を検証する

精度エラーをキャッチするための検証を実装します。秒単位のtimestampは、現在の日付について、おおよそ1,000,000,000(2001年9月)から2,000,000,000(2033年5月)の間に収まる必要があります。ミリ秒timestampは約1,000倍大きくなるはずです。これらのエラーを早期にキャッチすることで、データの破損を防ぎます。

5. データベースのネイティブ型を考慮する

一部のデータベースは、組み込みの精度を持つネイティブのtimestamp型を提供しています。PostgreSQLのTIMESTAMP型は内部的にマイクロ秒の精度を保存します。MySQLのDATETIME型はバージョン5.6.4以降、マイクロ秒をサポートしています。これらのネイティブ型は、生の整数を保存するよりも優れたクエリ最適化を提供することがよくあります。

6. 分散システムでのクロックドリフトを考慮する

異なるサーバーによって生成されたtimestampを比較する場合、適切なクロック同期がなければ、ミリ秒の精度でさえ誤解を招く可能性があります。すべてのサーバーでNTP(ネットワークタイムプロトコル)を実装し、分散システムでイベントを順序付けるために論理クロック(Lamport timestampやベクタークロックなど)の使用を検討してください。

7. 変換ロジックを徹底的にテストする

精度レベル間で変換する際は、負のtimestamp(1970年以前の日付)、非常に大きなtimestamp(遠い将来の日付)、整数型の境界などのエッジケースをテストします。32ビット整数は2038年以降のミリ秒timestampを保存できません。

8. 2038年問題を計画する

秒レベルのtimestampを使用している場合は、32ビットではなく64ビット整数を使用していることを確認してください。2038年問題は32ビット符号付き整数にのみ影響します。Unix timestampチュートリアルのベストプラクティスに従うことで、アプリケーションを将来にわたって使用できるようになります。

まとめ

Unix timestampの秒 vs ミリ秒 vs マイクロ秒の選択は、任意の技術的な好みではなく、特定のアプリケーション要件によって決まります。秒レベルの精度はほとんどのユーザー向け機能を効率的に処理し、ミリ秒の精度はAPIモニタリングとリアルタイム調整を可能にし、マイクロ秒の精度は特殊な高頻度アプリケーションに対応します。ニーズを満たす最もシンプルなオプションから始め、関連データ内で一貫性を保ち、選択を明確に文書化してください。ストレージ、パフォーマンス、精度の実用的なトレードオフを理解することで、アプリケーションの成長に合わせてスケールする情報に基づいた決定を下すことができます。

timestamp形式を即座に変換

timestamp形式を即座に変換

無料のUnix timestampコンバーターで、秒、ミリ秒、マイクロ秒を切り替えます。コーディング不要です。

無料ツールを試す →