Когда ты работаешь с Unix timestamp, выбор между секундами, миллисекундами и микросекундами может существенно повлиять на производительность твоего приложения, требования к хранению и точность. Хотя Unix timestamp традиционно измеряют время в секундах с 1 января 1970 года, современные приложения часто требуют более высокой точности для логирования событий, измерения времени отклика API или синхронизации распределённых систем. Это руководство разбирает практические различия между каждым уровнем точности и предоставляет чёткие критерии, которые помогут тебе сделать правильный выбор для твоего конкретного случая использования.

Содержание

Понимание трёх уровней точности

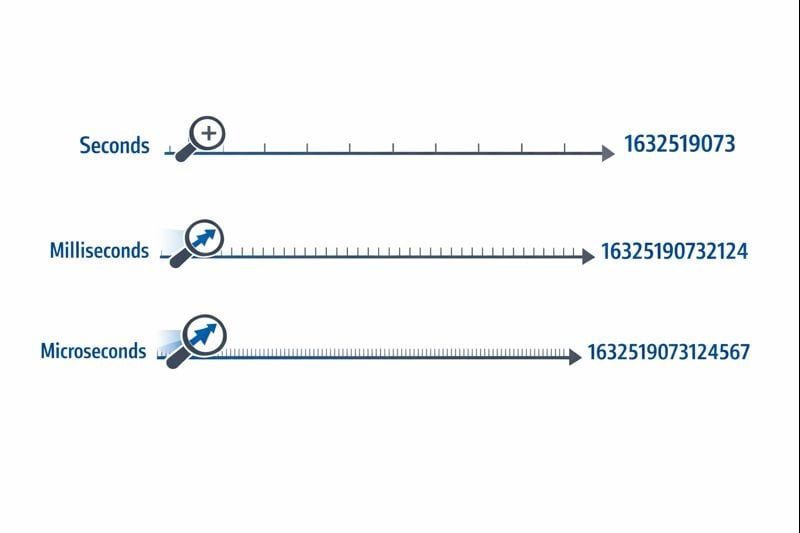

Unix timestamp представляет время как одно число, отсчитываемое от точки отсчёта epoch time. Уровень точности определяет, насколько детально ты можешь измерять временные интервалы.

Секунды (10 цифр): Оригинальный формат Unix timestamp использует 32-битное или 64-битное целое число, представляющее целые секунды. Типичное значение выглядит как 1704067200

, что представляет точно один момент времени без подразделений.

Миллисекунды (13 цифр): Этот формат умножает значение секунд на 1000, добавляя три десятичных знака точности. Тот же момент становится 1704067200000

. Функция JavaScript Date.now()

возвращает timestamp в этом формате по умолчанию.

Микросекунды (16 цифр): Используется в основном в системах, требующих экстремальной точности, этот формат умножает секунды на 1 000 000. Значение становится 1704067200000000

. Языки вроде Python с time.time_ns()

могут работать даже с наносекундной точностью (19 цифр), хотя микросекунды представляют практический верхний предел для большинства приложений.

Выбранный тобой уровень точности напрямую влияет на размер твоей базы данных, потребление памяти и производительность запросов. Эти ограничения становятся критичными по мере масштабирования твоего приложения.

Требования к хранению

32-битное целое число (4 байта) может хранить timestamp на уровне секунд до наступления проблемы 2038 года. Большинство современных систем используют 64-битные целые числа (8 байт), чтобы избежать этого ограничения.

- Секунды: 8 байт для знакового 64-битного целого числа (BIGINT)

- Миллисекунды: 8 байт для знакового 64-битного целого числа (BIGINT)

- Микросекунды: 8 байт для знакового 64-битного целого числа (BIGINT)

Хотя каждый уровень точности использует одинаковые 8 байт хранения в современных базах данных, реальное влияние исходит от операций индексирования и запросов. Большие числа требуют больше циклов процессора для операций сравнения, а B-деревья индексов становятся немного менее эффективными с большими значениями ключей.

Производительность запросов к базе данных

Когда ты работаешь с Unix timestamp в базах данных, уровень точности влияет на запросы диапазонов и операции сортировки. База данных, сравнивающая 10-значные числа, работает незначительно быстрее, чем при сравнении 16-значных чисел, хотя разница становится заметной только при миллионах строк.

Что более критично, смешивание уровней точности в твоей базе данных создаёт накладные расходы на преобразование. Если твой прикладной уровень отправляет timestamp в миллисекундах, а база данных хранит секунды, каждый запрос требует деления на 1000, что препятствует эффективному использованию индекса.

Соображения по сети и API

JSON-пейлоады передают timestamp как строки или числа. 16-значный timestamp в микросекундах добавляет 6 дополнительных символов по сравнению с 10-значным timestamp в секундах. При миллионах вызовов API это добавляет измеримые затраты на пропускную способность и накладные расходы на сериализацию.

Когда использовать секунды

Точность на уровне секунд остаётся лучшим выбором для большинства пользовательских функций, где человеческое восприятие определяет релевантную временную шкалу.

Идеальные случаи использования

- Посты и комментарии в соцсетях: Пользователи не воспринимают различия меньше одной секунды

- Запланированные задачи и cron-задания: Большинство автоматизаций работают с границами минут или часов

- Токены аутентификации пользователей: Истечение сессии не требует точности меньше секунды

- Даты публикации контента: Статьи, видео и посты в блогах используют точность на уровне секунд

- Системы бронирования и резервирования: Встречи обычно выравниваются по минутам или часам

Практические шаги реализации

Чтобы эффективно реализовать timestamp на уровне секунд:

- Используй столбцы

BIGINTв своей базе данных для хранения знаковых 64-битных целых чисел - Создай индексы на столбцах timestamp для запросов диапазонов типа «посты за последние 24 часа»

- В JavaScript конвертируй timestamp в миллисекундах:

Math.floor(Date.now() / 1000) - В Python используй:

int(time.time()) - Задокументируй свой выбор точности в спецификациях API, чтобы потребители знали, нужно ли умножать на 1000

Когда использовать миллисекунды

Точность в миллисекундах становится необходимой, когда тебе нужно отслеживать события, происходящие несколько раз в секунду, или измерять длительности короче одной секунды.

Идеальные случаи использования

- Мониторинг времени отклика API: Отслеживание, отвечают ли эндпоинты за 200 мс или 800 мс

- Финансовые транзакции: Запись точной последовательности сделок или шагов обработки платежей

- Обмен сообщениями в реальном времени: Упорядочивание сообщений чата, отправленных в течение одной секунды

- Аналитика видеостриминга: Запись событий воспроизведения и инцидентов буферизации

- Координация распределённых систем: Синхронизация событий между несколькими серверами

Практические шаги реализации

Чтобы реализовать timestamp на уровне миллисекунд:

- Используй столбцы

BIGINTв своей базе данных с чёткой документацией, что значения представляют миллисекунды - В JavaScript используй

Date.now()напрямую (он возвращает миллисекунды по умолчанию) - В Python используй:

int(time.time() * 1000) - Для Discord timestamp и подобных платформ миллисекунды обеспечивают стандартную точность

- Добавь валидацию на уровне приложения, чтобы убедиться, что timestamp попадают в разумные диапазоны (не случайно в секундах или микросекундах)

Реальные ограничения

Точность в миллисекундах вводит тонкую проблему: не все системы генерируют действительно точные timestamp в миллисекундах. Разрешение системных часов варьируется, а виртуализированные среды могут обновлять свои часы только каждые 10-15 миллисекунд. Твои timestamp могут показывать ложную точность, если базовые часы не поддерживают истинную точность в миллисекундах.

Когда использовать микросекунды

Точность в микросекундах избыточна для большинства приложений, но становится необходимой в специализированных областях, требующих экстремальной точности.

Идеальные случаи использования

- Высокочастотные торговые системы: Запись обновлений книги заказов, происходящих тысячи раз в секунду

- Профилирование производительности и бенчмаркинг: Измерение времени выполнения функций в диапазоне микросекунд

- Научный сбор данных: Логирование показаний датчиков или экспериментальных измерений

- Анализ сетевых пакетов: Фиксация точного времени сетевых событий для безопасности или отладки

- Обработка аудио/видео: Синхронизация мультимедийных потоков на уровне кадров или сэмплов

Практические шаги реализации

Чтобы реализовать timestamp на уровне микросекунд:

- Проверь, что твой язык программирования и база данных поддерживают точность в микросекундах (не все поддерживают)

- В Python используй:

int(time.time() * 1_000_000) - В C/C++ используй

gettimeofday()илиclock_gettime()сCLOCK_REALTIME - Рассмотри использование специализированных баз данных временных рядов, таких как InfluxDB или TimescaleDB, разработанных для timestamp высокой точности

- Чётко задокументируй требование к точности, так как большинство разработчиков будут предполагать миллисекунды по умолчанию

Реальные ограничения

Timestamp в микросекундах создают значительные проблемы в распределённых системах. Задержка сети обычно измеряется в миллисекундах, что делает синхронизацию на уровне микросекунд между серверами практически невозможной без специализированного оборудования, такого как часы с GPS-синхронизацией. Если твоё приложение работает в нескольких дата-центрах, точность в микросекундах может обеспечить ложную точность.

Кейс: Система обработки заказов в электронной коммерции

Гипотетический кейс:

Следующий пример демонстрирует принятие решений в реальном мире для точности timestamp. Хотя компания вымышленная, технические ограничения и решения представляют распространённые сценарии.

ShopFast, средняя по размеру платформа электронной коммерции, изначально построила свою систему обработки заказов с использованием Unix timestamp на уровне секунд. По мере масштабирования до обработки 500 заказов в минуту в часы пик они столкнулись с критической проблемой.

Проблема

Несколько заказов, размещённых в течение одной секунды, не могли быть надёжно отсортированы. Когда клиенты обращались в поддержку с вопросом «какой заказ прошёл первым?», система не могла дать определённый ответ. Что более критично, их система обнаружения мошенничества должна была помечать случаи, когда одна и та же кредитная карта использовалась для нескольких покупок в короткий промежуток времени, но точность на уровне секунд делала это ненадёжным.

Анализ

Команда разработчиков оценила свои требования по различным компонентам системы:

- Timestamp создания заказа: Требовалась точность в миллисекундах для правильного упорядочивания

- Поля last_updated каталога продуктов: Точность в секундах оставалась достаточной

- Логи обработки платежей: Требовалась точность в миллисекундах для обнаружения мошенничества

- Даты создания учётных записей клиентов: Точность в секундах оставалась достаточной

- Логирование API-запросов: Требовалась точность в миллисекундах для мониторинга производительности

Решение

Вместо конвертации всей базы данных в миллисекунды они реализовали гибридный подход:

- Мигрировали

orders.created_atиз секунд в миллисекунды, умножив существующие значения на 1000 - Обновили свой слой API для приёма и возврата timestamp в миллисекундах для эндпоинтов, связанных с заказами

- Оставили пользовательские timestamp (создание аккаунта, последний вход) в секундах, чтобы минимизировать объём миграции

- Добавили чёткую документацию, различающую, какие поля используют какую точность

- Реализовали валидацию на уровне приложения для отлова случайных несоответствий точности

Результаты

После миграции система могла надёжно упорядочивать заказы и обнаруживать паттерны мошенничества. Увеличение хранения было незначительным (добавление трёх цифр к существующим числам), но улучшенная функциональность оправдала усилия по миграции. Производительность запросов осталась практически идентичной, так как они поддерживали правильную индексацию.

Ключевой урок: тебе не нужна единообразная точность во всём приложении. Выбирай подходящий уровень для каждого конкретного случая использования на основе реальных требований, а не теоретических соображений.

Лучшие практики выбора точности timestamp

Следуй этим рекомендациям при реализации Unix timestamp в своих приложениях:

1. Начинай с секунд, обновляй только при необходимости

По умолчанию используй точность на уровне секунд, если у тебя нет конкретного требования к более тонкой детализации. Преждевременная оптимизация тратит время разработки и создаёт ненужную сложность. Большинству приложений никогда не нужна точность меньше секунды.

2. Поддерживай согласованность в рамках доменов

Используй один и тот же уровень точности для связанных timestamp. Если твоя таблица orders

использует миллисекунды, твои таблицы order_items

и order_payments

должны соответствовать. Смешивание уровней точности заставляет постоянно конвертировать и создаёт баги.

3. Документируй свой выбор точности

Добавляй комментарии в схему своей базы данных, документацию API и код, объясняющие, представляют ли timestamp секунды, миллисекунды или микросекунды. Значение timestamp 1704067200000

неоднозначно без контекста.

4. Валидируй диапазоны timestamp

Реализуй валидацию для отлова ошибок точности. Timestamp в секундах должен попадать примерно между 1 000 000 000 (сентябрь 2001) и 2 000 000 000 (май 2033) для текущих дат. Timestamp в миллисекундах должен быть примерно в 1000 раз больше. Раннее обнаружение этих ошибок предотвращает повреждение данных.

5. Учитывай нативные типы твоей базы данных

Некоторые базы данных предлагают нативные типы timestamp со встроенной точностью. Тип PostgreSQL TIMESTAMP

хранит точность в микросекундах внутренне. Тип MySQL DATETIME

поддерживает микросекунды с версии 5.6.4. Эти нативные типы часто обеспечивают лучшую оптимизацию запросов, чем хранение сырых целых чисел.

6. Учитывай дрейф часов в распределённых системах

Если ты сравниваешь timestamp, сгенерированные разными серверами, даже точность в миллисекундах может вводить в заблуждение без правильной синхронизации часов. Реализуй NTP (Network Time Protocol) на всех серверах и рассмотри использование логических часов (таких как timestamp Лампорта или векторные часы) для упорядочивания событий в распределённых системах.

7. Тщательно тестируй логику конвертации

При конвертации между уровнями точности тестируй граничные случаи, такие как отрицательные timestamp (даты до 1970 года), очень большие timestamp (даты далёкого будущего) и границы твоих целочисленных типов. 32-битное целое число не может хранить timestamp в миллисекундах после 2038 года.

8. Планируй проблему 2038 года

Если ты используешь timestamp на уровне секунд, убедись, что используешь 64-битные целые числа, а не 32-битные. Проблема 2038 года затрагивает только 32-битные знаковые целые числа. Следование лучшим практикам руководства по Unix timestamp помогает сделать твоё приложение устойчивым к будущему.

Заключение

Выбор между секундами, миллисекундами и микросекундами для Unix timestamp зависит от твоих конкретных требований приложения, а не от произвольных технических предпочтений. Точность на уровне секунд эффективно обрабатывает большинство пользовательских функций, точность в миллисекундах обеспечивает мониторинг API и координацию в реальном времени, а точность в микросекундах служит специализированным высокочастотным приложениям. Начинай с простейшего варианта, который удовлетворяет твоим потребностям, поддерживай согласованность в связанных данных и чётко документируй свой выбор. Понимая практические компромиссы между хранением, производительностью и точностью, ты можешь принимать обоснованные решения, которые масштабируются вместе с ростом твоего приложения.

Мгновенно конвертируй между форматами timestamp

Мгновенно конвертируй между форматами timestamp

Переключайся между секундами, миллисекундами и микросекундами с нашим бесплатным конвертером Unix timestamp. Программирование не требуется.

Попробуй наш бесплатный инструмент →